Saltar a un capítulo clave

Introducción a Webcrawler

En el vasto y fascinante reino de la informática, un subconjunto único se dedica al proceso de exploración e indexación de la World Wide Web. Ahí es donde se encuentra el término "Webcrawler". Para comprender el papel fundamental de un webcrawler, o "araña" en la jerga informática, es esencial saber qué es y cómo funciona exactamente.¿Qué es un Webcrawler?

Un Webcrawler es un robot de Internet que navega sistemáticamente por la World Wide Web con el fin de indexarla. A menudo lo utilizan los motores de búsqueda para escanear y copiar páginas web para su procesamiento e indexación.

function webcrawler(seed) { let ToVisit = [seed] let Visited = [] while (ToVisit.length > 0) { let currentUrl = ToVisit.pop() if (!Visited.includes(currentUrl)) { Visited.push(currentUrl) let webpageContent = fetchWebpage(currentUrl) let newUrls = extractUrls(webpageContent) ToVisit.push(...newUrls) } } return Visited }En el contexto del rastreo web, `fetchWebpage` y `extractUrls` son funciones que recuperan el HTML de una página web y extraen las URL del HTML, respectivamente. Este pseudocódigo muestra el funcionamiento básico de un rastreador web, que va de una página a otra a través de los hipervínculos.

Aunque esto puede presentar un proceso sencillo, es crucial tener en cuenta que los rastreadores web reales manejan un gran volumen de información y complejidades como las "políticas de rastreo", determinar qué hacer con los enlaces descubiertos y gestionar la frecuencia de las visitas.

El propósito del Webcrawler en Informática

Los rastreadores web son esencialmente la columna vertebral de los motores de búsqueda. Tienen un propósito fundamental en la informática, ya que- Indexan la información en la web para facilitar una recuperación rápida y precisa

- Copian todas las páginas visitadas para crear un sitio espejo

- Acumulan datos para posteriores enfoques de minería de datos

- Validar hipervínculos y códigos HTML

| Paso 1 | Inicialización de las URL semilla |

| Paso 2 | Escanear las páginas web asociadas a las URL en tiempo real |

| Paso 3 | Identificar todos los hipervínculos de una página y añadirlos a una cola de URL a rastrear |

| Paso 4 | Repetir los pasos 2 y 3 hasta rastrear todas las páginas web relevantes |

Comprender la técnica del rastreador web

Profundizando en el dominio de un webcrawler, es vital comprender su técnica, que sustenta todo el entramado. Esto implica principalmente comprender los principios críticos de la técnica del webcrawler y su papel en una red informática.Principios básicos de la técnica del rastreador web

Los fundamentos básicos de la técnica webcrawler constan fundamentalmente de varios componentes. Profundicemos en estos principios subyacentes:- Generación de semillas: Webcrawler comienza con URL "semilla" iniciales. Son los puntos de partida desde los que el webcrawler comienza su viaje de exploración de páginas.

- Obtención de URL: Un webcrawler recupera el contenido HTML de la URL actual que se está visitando. Esto puede hacerse mediante una simple petición HTTP GET.

- Extracción de URL: Todas las URL incluidas en el contenido HTML obtenido se extraen y se añaden a una lista de URL que deben visitarse a continuación, también conocida como "frontera de rastreo".

- Procesamiento de datos: La información del contenido HTML, como los metadatos o el cuerpo del texto, se procesa y almacena para su uso posterior.

- Política de cortesía: Los rastreadores web respetan el "retardo de rastreo" identificado en el archivo robots.txt de los sitios web para evitar sobrecargar el servidor.

function webCrawler(seedUrls, delay) { let ToVisit = [...seedUrls] let Visited = [] while (ToVisit.length > 0) { let currentUrl = ToVisit.pop() if (!Visited.includes(currentUrl)) { Visited.push(currentUrl) let webpageContent = fetchWebpage(currentUrl) let newUrls = extractUrls(webpageContent) ToVisit.push(...newUrls) delayCrawl(delay) } } return Visited }Esta función ejemplifica la implementación de un webcrawler, teniendo en cuenta el "retraso" estipulado por la "política de cortesía".El papel del rastreador web en una red informática

Un rastreador web desempeña un papel fundamental en las redes informáticas. Ayuda principalmente a recopilar e indexar datos en sistemas interconectados. Su utilidad principal se experimenta sobre todo en las siguientes áreas:- Motores de búsqueda: Los webcrawlers son indispensables para los motores de búsqueda como Google, que deben indexar una cantidad insondable de datos. El webcrawler ayuda a descubrir información actualizada y añadirla a la base de datos del buscador.

- Reflejo de datos: Los webcrawlers pueden construir un "espejo" de los datos encontrados en la web. Esto implica esencialmente la creación de un duplicado de los datos originales que puede redistribuirse.

- Seguridad de la red: Los rastreadores web también pueden desempeñar un papel en la seguridad de la red. Pueden ayudar a identificar posibles brechas de seguridad o vulnerabilidades en la infraestructura de la red.

Ejemplos reales de rastreadores web

Algunos ejemplos de webcrawlers con los que quizá ya estés familiarizado son Googlebot y Bingbot. Googlebot, el webcrawler de Google, utiliza un proceso algorítmico: 1. 1. Rastreo: El proceso comienza con la obtención de una lista de páginas web. Googlebot encuentra páginas nuevas y actualizadas para añadirlas al índice de Google a través de enlaces. 2. Indexación. 2. Indexación: Durante este proceso, Googlebot procesa cada una de las páginas que rastrea para compilar un índice masivo de todas las palabras que ve y su ubicación en cada página. Bingbot funciona de forma similar, ayudando a mejorar los resultados de búsqueda en el motor de búsqueda Bing de Microsoft. Estos dos robots utilizan webcrawlers basados en los principios y técnicas señalados anteriormente. Navegan continuamente por la web, indexando sitios web y ayudando a que tus búsquedas online sean más precisas y eficientes. Entender estos ejemplos puede ayudarte a comprender mejor la importancia y utilidad de los webcrawlers en las redes informáticas.Crear un motor de búsqueda webcrawler

En el vasto universo digital, crear un motor de búsqueda webcrawler no es poca cosa. Va mucho más allá de la codificación intencionada. El proceso es una ciencia en sí mismo que merece una comprensión completa de la intrincada mecánica que hay detrás del rastreo web.Motor de búsqueda webcrawler: ¿Cómo funciona?

Entonces, ¿cómo funciona un motor de búsqueda webcrawler? Es un convincente mecanismo sinérgico que funciona con los principios básicos de codificación del rastreo y la indexación. Para diseccionarlo- Rastreo: El rastreador web comienza con una lista de URL que debe visitar, denominada "semilla". A medida que visita estas URL, identifica todos los hipervínculos de la página y los añade a su lista de páginas a visitar a continuación.

- Índice: Tras el proceso de rastreo, el webcrawler iniciará el proceso de indexación. Aquí es donde se guarda el texto real de cada página visitada y se cataloga adecuadamente para recuperarlo rápidamente cuando se realice una búsqueda.

| Paso 1 | Crea una lista de las URL "semilla" por las que empezará a navegar tu rastreador. |

| Paso 2 | Configura tu webcrawler para que obtenga el contenido HTML de la siguiente URL no visitada de la lista. |

| Paso 3 | Extrae todas las URL enlazadas desde la página obtenida y añádelas a la lista de URL que visitarás a continuación. |

| Paso 4 | Analiza el contenido de la página para separar el texto real del código HTML. |

| Paso 5 | Indexa el contenido de la página para facilitar su recuperación utilizando una estructura de datos conocida como índice invertido. Una representación simplificada de un índice invertido puede venir dada por la función \( f: \text{{palabra}} \rightarrow \text{{lista de IDs de documentos}} \). |

| Paso 6 | Repite los pasos 2 a 5 hasta que se hayan visitado todas las URL, vigilando y respetando los retrasos de rastreo establecidos en el archivo "robots.txt" de cada sitio. |

¡function webcrawlerSearchEngine(seedUrls, delay, index) { let ToVisit = [...seedUrls] let Visited = [] while (ToVisit.length > 0) { let currentUrl = ToVisit.pop() if (!Visited.includes(currentUrl)) { Visited.push(currentUrl) let webpageContent = fetchData(currentUrl) let newUrls = extractUrls(webpageContent) ToVisit.push(...newUrls) delayCrawl(delay) let webpageText = parseHTML(webpageContent) indexPage(currentUrl, webpageText, index)}}Esta función ilustra la implementación de un motor de búsqueda webcrawler básico, teniendo en cuenta el "retraso" estipulado por la "política de cortesía", y una funcionalidad de indexación sencilla.

Importancia e impacto de un motor de búsqueda webcrawler

Un motor de búsqueda webcrawler tiene un impacto inmenso tanto en los usuarios como en los motores de búsqueda. Permite una recuperación de datos rápida y eficaz y refuerza la precisión de los resultados de búsqueda.- Mejores resultados de búsqueda: Dado que los rastreadores web peinan e indexan grandes cantidades de datos, ayudan a mejorar la relevancia y la calidad de los resultados de búsqueda.

- Velocidad y eficacia: Con una indexación exhaustiva, los motores de búsqueda pueden ofrecer resultados a una velocidad pasmosa.

- Estructura y conectividad: Los rastreadores web ayudan a mapear la estructura y conectividad de la web siguiendo los enlaces que rastrean. Esta es una característica clave para evaluar la calidad y relevancia de una página, según algoritmos como el Page Rank de Google.

Aplicación de Python para un Webcrawler

Una de las formas más populares de construir un webcrawler hoy en día es utilizando Python. Este lenguaje de programación de alto nivel es famoso por su sencillez y legibilidad, por lo que resulta adecuado para tareas complejas como la creación de un rastreador web. Además de ser de código abierto, Python cuenta con potentes bibliotecas como Beautiful Soup y Scrapy, que simplifican aún más el proceso de escribir un rastreador web.Cómo utilizar Python para crear un rastreador web

Construir un webcrawler utilizando Python es factible con librerías muy potentes. El procedimiento incluye principalmente la generación de URL a visitar (denominadas semillas), la obtención y análisis de los datos de la página web y, a continuación, la extracción de los enlaces para las siguientes visitas. La biblioteca Beautiful Soup de Python se utiliza mucho para analizar documentos HTML y XML. Crea un árbol de análisis sintáctico a partir de las fuentes de la página que puede utilizarse para extraer datos de forma jerárquica y más legible. Aquí tienes un fragmento de código Python que utiliza Beautiful Soup para analizar HTML:from bs4 import BeautifulSoup import requests def crawl(url): content = requests.get(url) soup = BeautifulSoup(content.text, 'html.parser') for link in soup.find_all('a'): print(link.get('href'))En este código, `requests.get(url)` obtiene el contenido de la página, luego lo analiza Beautiful Soup y, por último, se recuperan e imprimen todas las URL de los hipervínculos. Además, Python promociona la biblioteca Scrapy, un completo marco para el rastreo web. Proporciona todas las herramientas necesarias para extraer datos de sitios web, procesarlos y guardarlos en la estructura preferida. Es robusta, rápida y versátil.

Mientras que Beautiful Soup ayuda a analizar el código HTML y extraer datos, Scrapy ofrece funciones más avanzadas, como la gestión de solicitudes y canalizaciones para almacenar datos, lo que lo hace práctico para construir rastreadores incluso a gran escala.Webcrawler Python: Ejemplos y códigos

Veamos un ejemplo sencillo de un rastreador web en Python que utiliza Beautiful Soup y peticiones para obtener URLs de una página web.

from bs4 import BeautifulSoup import requests def webcrawler(seedUrl): response = requests.get(seedUrl) page_content = response.content soup = BeautifulSoup(page_content, 'html.parser') urls = [a['href'] for a in soup.find_all('a', href=True)] return urlsEn esta función de Python, `requests.get()` obtiene el contenido de una página web. A continuación, se utiliza Beautiful Soup para analizar el contenido de la página. Por último, se encuentran y devuelven todas las urls de esa página. Para un rastreador más avanzado, se puede recurrir a la biblioteca Scrapy. Es una potente herramienta para construir rastreadores web más avanzados. Sin embargo, su uso no es tan sencillo como el de Beautiful Soup, y aprenderlo puede llevar algún tiempo.

Puntos clave para crear un rastreador web en Python

Al utilizar Python para crear un webcrawler, deben tenerse en cuenta los siguientes puntos, que suelen aplicarse:- Respetar Robots.txt: Antes de empezar a rastrear un sitio web, asegúrate de comprobar su archivo robots.txt. Este archivo contiene las políticas de rastreo del sitio web, las áreas que se te permite rastrear, el retardo del rastreo y la tasa de solicitud. Respetar estas normas es extremadamente importante para seguir la etiqueta de Internet y evitar sanciones. *

- Gestión de excepciones: Dada la naturaleza de Internet, tu rastreador web debe ser capaz de manejar todas las excepciones posibles con elegancia. Esto podría incluir la gestión de enlaces rotos o redirigidos.

- Multihilo: El rastreo es una operación que consume mucho tiempo. El uso de subprocesos múltiples puede acelerar significativamente tu rastreador web al permitirle visitar varias URL simultáneamente. *

- Almacenamiento de datos: Como un rastreador web recoge una gran cantidad de datos, debe implementarse un sistema adecuado de almacenamiento de datos. Puede ser tan sencillo como guardar los datos rastreados en un archivo o tan complejo como guardarlos en una base de datos, dependiendo de tus necesidades. *

Explorando el futuro de Webcrawler

A medida que nos adentramos en la progresión de la tecnología y su impacto en nuestras vidas, el futuro de los rastreadores web encierra un potencial apasionante. El dinámico mundo del rastreo de datos desvela un horizonte de oportunidades por explorar.La evolución del rastreador web: Pasado, presente y futuro

Los rastreadores web han recorrido un largo camino desde su creación a principios de los 90 con la llegada de los motores de búsqueda. Los rastreadores iniciales tenían una capacidad limitada y estaban diseñados principalmente para seguir el ritmo del contenido web en rápido crecimiento. El rastreador web clásico seguía un planteamiento relativamente sencillo:- Empezaba con una lista de URL a visitar, denominadas URL "semilla".

- Visita estas URL y recupera el contenido de la página.

- Analiza el contenido obtenido y busca las siguientes URL a visitar.

- Repite el proceso hasta que hayas visitado todos los sitios web relevantes.

Las técnicas innovadoras de los rastreadores web del futuro

En un futuro previsible, es probable que la innovación de los rastreadores web esté marcada por algunas tecnologías y conceptos de vanguardia:- Aprendizaje automático: Se prevé que desempeñe un papel importante en el rastreo de datos. Los rastreadores web podrían aprender el comportamiento y las preferencias del usuario a lo largo del tiempo, adaptándose para ofrecer una experiencia de navegación a medida.

- Comprensión semántica: Los rastreadores web pueden llegar a ser capaces de interpretar la semántica del contenido rastreado. Podrían diferenciar entre datos de aspecto similar basándose en su significado contextual, presentando resultados de búsqueda refinados y enriquecidos.

- Descentralización mejorada: A medida que navegamos hacia una Web más descentralizada, es evidente la necesidad de rastreadores Web descentralizados. Estos rastreadores de la Web3.0 rastrearían redes descentralizadas, creando así un índice más inclusivo de la web.

function webcrawlerML(seedUrl, model) { let ToVisit = [seedUrl] let Visited = [] while (ToVisit.length > 0) { let currentUrl = ToVisit.pop() if (!Visited.includes(currentUrl)) { Visited.push(currentUrl) let webpageContent = fetchData(currentUrl) let newUrls = extractUrls(webpageContent) let webpageText = parseHTML(webpageContent) let relevance =model.predict(webpageText) if (relevance > threshold) ToVisit.push(...newUrls) } } return Visited }En el ejemplo anterior, `model.predict()` es un modelo de aprendizaje automático que determina la relevancia de un texto. Si la relevancia del texto de la página supera un determinado umbral, el rastreador visita las URL de esa página. De hecho, el esplendor de los datos automatizados está llamado a alcanzar cotas asombrosas con los ambiciosos avances en los mecanismos de los rastreadores web. El potencial de interpretación y análisis automático de datos en los próximos años es un capítulo intrigante en la evolución de la World Wide Web. Con un impulso constante de mejora y adaptación, el futuro parece realmente prometedor para los rastreadores web. Su transformación a través de los tiempos se hace eco de la evolución dinámica de la tecnología, donde la adaptabilidad es clave, marcando una era de innovación excepcional en el ámbito de la indexación de datos web.

Webcrawler - Puntos clave

- Los rastreadores web comienzan con URL "semilla" iniciales que luego utilizan para buscar datos.

- Los rastreadores utilizan técnicas como la búsqueda de URL, en la que recuperan el contenido HTML de las URL, la extracción de URL y el procesamiento de datos, que incluye la extracción de información del HTML y su almacenamiento para un uso posterior.

- Los rastreadores web respetan el "retardo de rastreo" indicado en el archivo robots.txt de los sitios web como parte de la "Política de cortesía".

- Los rastreadores web ayudan en la optimización de los motores de búsqueda, la minería de datos, los sistemas de recuperación de información y el desarrollo web.

- Python es el lenguaje preferido para construir rastreadores web debido a su sencillez, legibilidad y potentes bibliotecas como Beautiful Soup y Scrapy.

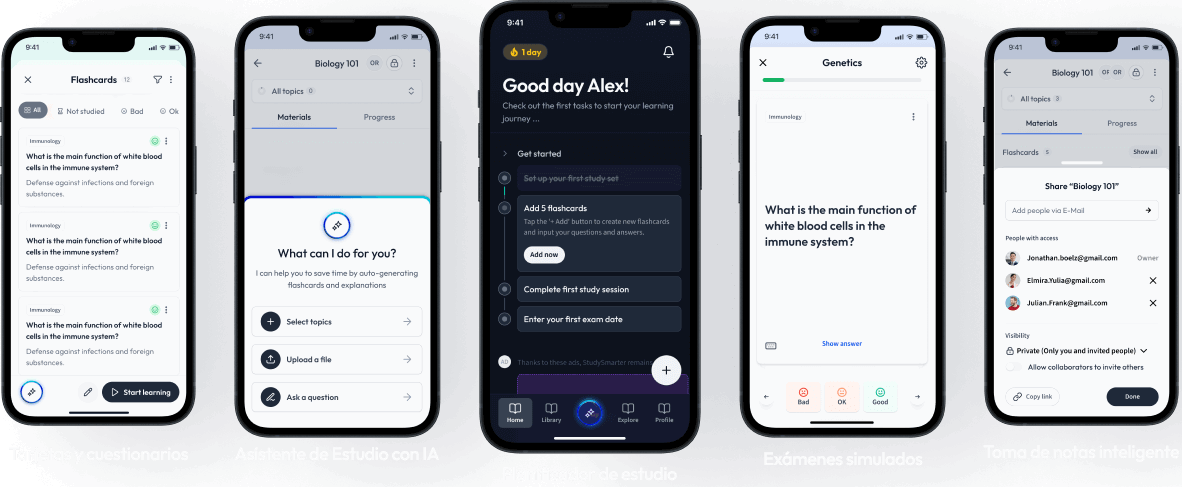

Aprende más rápido con las 15 tarjetas sobre Rastreador web

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Rastreador web

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más