Saltar a un capítulo clave

El papel de un ingeniero de Big Data es crucial en este ámbito; por tanto, explorar lo que hacen y las habilidades que poseen para alcanzar el éxito en su campo es indispensable. La analítica de Big Data es otra faceta que deberás explorar, comprendiendo cómo funciona y sus diversas aplicaciones.

Por último, necesitas comprender las 4 V de Big Data -volumen, variedad, velocidad y veracidad-, su importancia en la gestión de Big Data y por qué son integrales para aprovechar el potencial de Big Data. En resumen, esta guía es tu puerta de entrada para adquirir una comprensión en profundidad del Big Data y su profundo impacto en el mundo moderno.

Los Grandes Datos: Definición

Big Data es un concepto popular en el mundo de la tecnología y la informática. Esencialmente, Big Data se refiere a una riqueza de información tan vasta en volumen, variedad y velocidad que los métodos convencionales de tratamiento de datos se quedan cortos. Para apreciar realmente lo que implica el Big Data, es esencial comprender su historia, características clave, fuentes y aplicaciones en el mundo real, entre otros elementos.

Aunque no existe una definición fija, Big Data se refiere generalmente a conjuntos de datos que son tan grandes o complejos que el software tradicional de aplicaciones de procesamiento de datos es inadecuado para manejarlos.

Significado de Big Data

El término Big Data trasciende el mero tamaño o volumen de los conjuntos de datos. No obstante, hay tres características clave (o Vs) que suelen asociarse a los Big Data:

- Volumen: Se refiere al mero tamaño de los datos que se procesan. Es esta característica la que a menudo requiere métodos de procesamiento poco convencionales.

- Velocidad: Se refiere a la velocidad a la que se generan y procesan los datos.

- Variedad: Las formas de datos que se manejan son diversas, desde datos estructurados a semiestructurados y no estructurados.

Sin embargo, a medida que el big data sigue evolucionando, han surgido Vs adicionales como la Veracidad, el Valor y la Variabilidad. Éstas representan la veracidad de los datos, la utilidad de la información extraída y la inconsistencia de los datos a lo largo del tiempo, respectivamente.

El contexto histórico del Big Data

Debemos el término "Big Data" a un artículo publicado por Erik Larson en el "American Scientist" allá por 1989. Sin embargo, la importancia de la recopilación de datos a gran escala es incluso anterior. Por ejemplo, en 1880, la Oficina del Censo de EE.UU. desarrolló un sistema de tarjetas perforadas para gestionar grandes cantidades de información.

Históricamente, Big Data se refiere a la idea de manejar y dar sentido a grandes cantidades de información. En esencia, se trata de recopilar, almacenar y procesar el creciente mar de datos generados por las tecnologías digitales.

Pensemos en Google, el motor de búsqueda más dominante del mundo. Procesan más de 3.500 millones de solicitudes al día. Los sistemas tradicionales de procesamiento de datos se tambalearían ante una presión de datos tan inmensa. De ahí que confíen en las tecnologías de Big Data para almacenar e interpretar estas enormes cantidades de datos de búsqueda.

La empresa de investigación IDC ha pronosticado que en 2025 habrá unos 175 zettabytes de datos en el mundo. Esta cantidad astronómica de datos pone de relieve la importancia y relevancia cada vez mayores de los Big Data. Estar equipado con una sólida comprensión y capacidad para trabajar con Big Data seguirá siendo una habilidad crucial en los campos de la tecnología y la informática.

Tecnologías de Big Data: Dar sentido a la información masiva

El procesamiento de Big Data es prácticamente imposible con los medios tradicionales. Por ello, se han desarrollado numerosas herramientas y tecnologías para manejar el volumen, la velocidad y la variedad asociados a ellos. Estas herramientas tienen como objetivo extraer ideas significativas, garantizar la precisión y añadir valor a las empresas o a la investigación. Aprende más sobre los tipos de tecnologías de Big Data, cómo funcionan y ejemplos de cómo se utilizan en diversos sectores.

Herramientas y tecnologías innovadoras para el Big Data

Constantemente se están innovando varias herramientas y tecnologías para ayudar a navegar eficazmente por las impredecibles aguas del Big Data. Desde plataformas de software a herramientas de minería de datos, pasando por soluciones basadas en la nube, estas tecnologías presentan diversas capacidades para las distintas fases del ciclo de vida del Big Data.

A continuación se enumeran algunas de las tecnologías de Big Data más utilizadas:

- Apache Hadoop: Se trata de un marco de código abierto que permite el procesamiento distribuido de grandes conjuntos de datos a través de clusters de ordenadores. Está diseñado para escalar desde servidores individuales a miles de máquinas, cada una de las cuales ofrece computación y almacenamiento locales.

- Apache Spark: Spark, un rápido motor de procesamiento de datos en memoria diseñado para ofrecer velocidad y facilidad de uso, puede conectarse a clusters Hadoop para acelerar las tareas de procesamiento de datos.

- Bases de datos NoSQL: Son sistemas de gestión de datos no relacionales diseñados para proporcionar una gran velocidad operativa, rendimiento y escalabilidad para grandes cantidades de datos, lo que no es posible con las bases de datos tradicionales.

- Plataformas de Aprendizaje Automático: El aprendizaje automático es un tipo de inteligencia artificial (IA) que proporciona a los sistemas la capacidad de aprender y mejorar a partir de la experiencia sin ser programados explícitamente. Las plataformas de aprendizaje automático ofrecen herramientas y algoritmos para automatizar la creación de modelos analíticos.

| Tecnología | Utiliza |

|---|---|

| Apache Hadoop | Procesamiento distribuido de grandes conjuntos de datos en clusters de ordenadores |

| Apache Spark | Acelera las tareas de procesamiento de datos |

| Bases de datos NoSQL | Gestionan grandes cantidades de datos no relacionales |

| Plataformas de aprendizaje automático | Automatizan la creación de modelos analíticos |

Las tecnologías de Big Data representan el conjunto de utilidades de software, marcos y dispositivos de hardware que se pueden utilizar para capturar, almacenar, gestionar y realizar consultas complejas sobre grandes conjuntos de datos.

Ejemplos de tecnologías de Big Data en uso hoy en día

Las tecnologías de Big Data están transformando diversos sectores, como la sanidad, la educación, el comercio electrónico, las finanzas, etc. Comprender las aplicaciones prácticas puede arrojar más luz sobre su relevancia y potencial.

Un ejemplo excelente de empresa que utiliza tecnologías de Big Data es Amazon, el gigante minorista. Amazon aprovecha el poder de las tecnologías de Big Data para analizar las preferencias, el comportamiento de compra y los intereses de sus clientes para personalizar las recomendaciones. Amazon también utiliza Big Data para prever la demanda, optimizar los precios, mejorar la logística, etc.

Si nos fijamos en el sector sanitario, las tecnologías de Big Data se utilizan para el análisis predictivo con el fin de mejorar la atención al paciente. Por ejemplo, el proyecto DeepMind Health de Google recopila datos de pacientes para ayudar a los profesionales sanitarios a predecir enfermedades y prescribir intervenciones en las primeras fases para mejorar los resultados de los pacientes.

Los bancos y las instituciones financieras aprovechan las tecnologías de Big Data para detectar transacciones fraudulentas en tiempo real. Por ejemplo, los algoritmos de aprendizaje automático pueden aprender un patrón del gasto de un usuario y señalar cualquier transacción inusual.

Estos ejemplos son cada vez más comunes a medida que las empresas reconocen la abundancia y relevancia de los Big Data y las tecnologías diseñadas para manejarlos.

El papel de un ingeniero de Big Data

Un Ingeniero de Big Data desempeña un papel indispensable a la hora de abordar las complejidades de los Big Data. Al ser una figura fundamental en las empresas impulsadas por los datos, el Ingeniero de Big Data diseña, construye, prueba y mantiene arquitecturas como sistemas de procesamiento a gran escala y bases de datos. Comprender este papel, sus responsabilidades asociadas y las habilidades requeridas proporcionaría una visión del mundo de los Grandes Datos.

¿Qué hace un Ingeniero de Big Data?

Los Ingenieros de Big Data son los cerebros que construyen los sistemas responsables de recopilar, organizar y analizar los datos. Su papel crucial suele subestimarse e incomprenderse a pesar de su gran importancia para las empresas de diversos sectores.

En la lista de tareas diarias de un ingeniero de Big Data se materializa una plétora de actividades. Las tareas clave suelen incluir:

- Diseñar, gestionar y mantener el flujo de procesos, la arquitectura y el sistema de datos a gran escala.

- Construir arquitecturas escalables y de alto rendimiento para procesar y analizar datos.

- Desarrollar y configurar la comunicación en red.

- Garantizar que los sistemas cumplen los requisitos empresariales y las prácticas del sector.

- Integrando las nuevas tecnologías de gestión de datos y las fuentes de datos existentes.

La automatización es otro aspecto clave de su trabajo. Un Ingeniero de Big Data creará métodos automatizados para recopilar y preparar inmensas cantidades de datos para su análisis. Además, un Ingeniero de Big Data es responsable de ofrecer excelencia operativa, es decir, mantener la salud del sistema, garantizar la integridad de los datos y la seguridad del sistema.

Un Ingeniero de Big Data es un profesional que desarrolla, mantiene, prueba y evalúa soluciones de Big Data dentro de las organizaciones. Son responsables de diseñar, desarrollar, probar y mantener sistemas de gestión de datos altamente escalables.

Invertir en estos profesionales es crucial para las organizaciones que pretenden tomar la delantera en sus sectores, ya que los ingenieros desempeñan un papel muy importante en la transformación de Big Data en conocimientos procesables.

Pensemos en una gran empresa multinacional que gestiona millones de transacciones de clientes. El ingeniero de Big Data tiene la tarea de diseñar un sistema capaz de procesar, almacenar y analizar estas transacciones en tiempo real para proporcionar información valiosa a la dirección. Estos datos pueden utilizarse para tomar decisiones informadas, como orientar las campañas de marketing o identificar posibles áreas de expansión del negocio.

El trabajo de los ingenieros de Big Data va más allá del desarrollo y mantenimiento de sistemas. Se espera de ellos que se mantengan al tanto de las nuevas tendencias y tecnologías del sector, y que puedan influir en la arquitectura de futuras herramientas, promoviendo mejores técnicas de tratamiento, extracción y almacenamiento de datos. Esto implica asistir a seminarios y conferencias, participar en publicaciones del sector e incluso obtener certificaciones avanzadas en áreas como el aprendizaje automático y la computación en nube.

Habilidades necesarias para convertirse en un Ingeniero de Big Data de éxito

Los Ingenieros de Big Data necesitan una cartera de habilidades técnicas y no técnicas para maniobrar en las complejidades de la construcción y el mantenimiento de los sistemas de Big Data. Aquí enumeramos las habilidades fundamentales y deseables que pueden contribuir a una próspera carrera como Ingeniero de Big Data.

A continuación se enumeran las habilidades fundamentales imprescindibles:

- Programación: Los ingenieros de Big Data deben dominar lenguajes de programación como Java, Scala y Python.

- Sistemas de bases de datos: Deben poseer conocimientos prácticos de sistemas de bases de datos como SQL y NoSQL.

- Tecnologías de Big Data: El dominio de marcos de procesamiento de Big Data como Apache Hadoop, Spark, Flink, etc. es crucial.

Aparte de éstas, también son beneficiosas algunas habilidades técnicas específicas de las tecnologías de Big Data. Entre ellas se incluyen

- Soluciones de almacenamiento de datos

- Preparación de datos para la modelización predictiva y prescriptiva

- Técnicas de datos no estructurados

- Procesamiento de datos en tiempo real

- Conocimiento profundo de algoritmos y estructuras de datos

Además de las aptitudes técnicas, algunas aptitudes no técnicas destacables son

- Resolución de problemas: Dado que el Big Data consiste en manejar datos complejos, son imprescindibles las habilidades de resolución de problemas, el pensamiento analítico y la capacidad de trabajar bajo presión.

- Habilidades de comunicación: Necesitan articular datos complejos de forma clara, concisa y procesable para los miembros no técnicos del equipo.

- Trabajo en equipo: A menudo tienen que trabajar con científicos de datos, analistas y gestores; por tanto, ser un jugador de equipo es un atributo valioso.

Aprender estas habilidades puede parecer una tarea intimidatoria, pero un gran interés por los datos, junto con los recursos educativos y de aprendizaje adecuados, puede ayudar a allanar el camino para convertirse en un exitoso Ingeniero de Big Data.

Un Ingeniero de Big Data de éxito perfecciona una combinación única de habilidades técnicas, analíticas y blandas. Éstas ayudan a diseñar, construir y mantener la infraestructura de Big Data, transformando datos complejos en perspectivas comprensibles, y colaborando eficazmente con los equipos. Además, mantenerse al día con las tecnologías en evolución es un requisito.

Pensemos en el caso de una empresa financiera que quiere comprender el comportamiento de sus clientes para optimizar su oferta de productos. En este caso, un Ingeniero de Big Data aprovecha sus conocimientos técnicos para diseñar un sistema capaz de gestionar el desarrollo y el mantenimiento de Big Data. Además, utilizando sus habilidades de resolución de problemas, puede superar los retos que surjan durante el proceso. Sus habilidades de comunicación entran en juego al traducir los conocimientos recopilados en estrategias procesables para los equipos de marketing y producto.

Además, mantenerse al día de las tendencias y tecnologías en evolución potencia sus capacidades. Por ejemplo, si un nuevo marco de procesamiento de datos se presenta en el mercado prometiendo una mayor eficacia o facilidad de uso, un Ingeniero de Big Data bien informado puede evaluar su viabilidad para la arquitectura actual de la empresa e integrarlo potencialmente para lograr un rendimiento mejorado.

Profundizar en el análisis de Big Data

El análisis de Big Data consiste en examinar grandes conjuntos de datos para descubrir patrones ocultos, correlaciones, tendencias del mercado, preferencias de los clientes u otra información empresarial útil. Esta información puede analizarse para obtener perspectivas que conduzcan a mejores decisiones y movimientos empresariales estratégicos. Es la base del aprendizaje automático y la toma de decisiones basada en datos, que tienen un impacto significativo en el mundo de los negocios y la investigación.

Cómo funciona la Analítica de Grandes Datos

La Analítica de Big Data es un proceso complejo que suele constar de varias etapas. En el nivel más básico, implica recopilar los datos, procesarlos y, a continuación, analizar los resultados.

El primer paso consiste en la minería de datos, el proceso de extraer datos útiles de grandes conjuntos de datos. Esto implica una combinación de análisis estadístico, aprendizaje automático y tecnología de bases de datos para profundizar en grandes volúmenes de datos y extraer tendencias, patrones y perspectivas. Los datos extraídos suelen estar desestructurados y requieren limpieza, manipulación o segregación para prepararlos para la fase de procesamiento.

En la fase de procesamiento, los datos preparados se procesan utilizando diferentes técnicas en función del tipo de análisis requerido: procesamiento en tiempo real o por lotes. El procesamiento en tiempo real se utiliza generalmente para datos sensibles al tiempo en los que se necesita información instantánea. El procesamiento por lotes implica tratar con grandes volúmenes de datos almacenados, y el procesamiento suele programarse durante las horas de menor actividad.

El procesamiento por lotes es un método para ejecutar trabajos de datos repetitivos y de gran volumen. El método por lotes permite la ejecución de trabajos sin intervención humana, con la ayuda de una ventana de lotes que suele ser un periodo determinado en el que el uso del sistema es bajo.

El procesamiento en tiempo real consiste en procesar los datos en cuanto entran en el sistema. Requiere una infraestructura de alta velocidad y gran capacidad, ya que suele utilizarse para cálculos complejos que consumen muchos recursos y para la elaboración de informes en tiempo real.

Las herramientas y tecnologías utilizadas en esta fase suelen ser marcos de procesamiento de Big Data como Apache Hadoop, Apache Spark, etc. Hadoop, por ejemplo, utiliza el algoritmo MapReduce, en el que el conjunto de datos se divide en partes más pequeñas y se procesa simultáneamente. Este tipo de procesamiento se conoce como procesamiento paralelo.

Una vez procesados los datos, los científicos de datos o analistas de datos realizan el análisis real de los datos. Puede ser un análisis descriptivo, un análisis de diagnóstico, un análisis predictivo o un análisis prescriptivo.

- Análisis descriptivo: Este tipo de análisis explica lo que está ocurriendo. Resume los datos brutos de múltiples fuentes y los archiva de forma que puedan ser interpretados por humanos.

- Análisis diagnóstico: El análisis de diagnóstico profundiza en un problema para comprender la causa raíz. Utiliza métodos estadísticos para obtener información de los datos, como la diferencia entre los usuarios que abandonan y los que permanecen.

- Análisis predictivo: El análisis predictivo pretende predecir lo que es probable que ocurra en el futuro. Utiliza modelos estadísticos y técnicas de aprendizaje automático para comprender el comportamiento futuro.

- Análisis prescriptivo: El análisis prescriptivo sugiere un curso de acción. Utiliza técnicas de optimización y simulación para asesorar sobre los posibles resultados.

Una vez completado el análisis, hay que visualizar los resultados y comunicar los conocimientos a las partes interesadas para facilitar la toma de decisiones informadas y basadas en datos.

Por ejemplo, en un departamento de ventas que intenta aumentar los beneficios, el análisis de Big Data puede revelar que las ventas son mayores en determinadas zonas geográficas. Esta información podría llevar a los responsables de la toma de decisiones a centrar los esfuerzos de marketing en esas zonas, adaptando las estrategias para ampliar la base de clientes, lo que se traduciría en un aumento de las ventas y de la rentabilidad general.

Casos de uso de la Analítica de Grandes Datos

La Analítica de Grandes Datos está transformando la forma en que operan las empresas y organizaciones, impulsando la toma de decisiones con información basada en datos. Sus casos de uso son amplios y abarcan múltiples sectores. A continuación, tres ejemplos ilustrativos demuestran cómo la Analítica de Grandes Datos tiene un impacto significativo.

El primer ejemplo procede del sector minorista. Las plataformas de comercio electrónico como Amazon utilizan el Análisis de Grandes Datos para conocer los hábitos de compra de sus clientes, lo que permite personalizar su experiencia de compra en línea. Analizando los patrones de navegación y compra, Amazon puede recomendar productos adaptados a las preferencias de cada cliente, lo que contribuye a aumentar las ventas y la satisfacción de los clientes.

En el sector sanitario, el análisis de Big Data se utiliza para predecir brotes epidémicos, mejorar los tratamientos y comprender mejor las enfermedades. Por ejemplo, el proyecto Google Flu Trends intentó predecir brotes de gripe basándose en búsquedas relacionadas con la gripe y sus síntomas. Aunque el proyecto se interrumpió, puso de relieve el potencial de Big Data Analytics para predecir brotes de enfermedades.

En el campo de las finanzas, las instituciones bancarias están utilizando Big Data Analytics para la detección del fraude. Analizando comportamientos y patrones de gasto anteriores, los algoritmos de aprendizaje automático pueden identificar transacciones inusuales y señalarlas en tiempo real para su investigación, reduciendo el riesgo de fraude financiero.

Además, el Análisis de Datos Masivos desempeña un papel fundamental en la mejora de la ciberseguridad. Analizando datos históricos sobre ciberataques, los sistemas de seguridad pueden predecir e identificar posibles vulnerabilidades y mitigar los riesgos de forma proactiva, mejorando así la seguridad general de redes y sistemas.

Estos casos de uso ilustran cómo la analítica de Big Data explota las reservas de datos complejos y no estructurados para obtener información valiosa, lo que se traduce en una toma de decisiones basada en datos en diversos sectores.

Explorando las 4 V de los Grandes Datos

En el centro de la comprensión del Big Data, a menudo te encontrarás con el concepto denominado las "4 Vs". Para comprender realmente los grandes datos, es fundamental entender estas cuatro características clave que se asocian habitualmente a ellos: Volumen, Velocidad, Variedad y Veracidad. Comprender las 4 V proporcionará una visión global de las complejidades inherentes a la gestión de Big Data, y por qué es importante en el panorama de la gestión de datos.

Explicación de las 4 V

El Big Data suele describirse mediante cuatro características principales o Vs: Volumen, Velocidad, Variedad y Veracidad. Profundicemos en cada una de ellas.

Volumen

El volumen es la V más comúnmente asociada a los Grandes Datos y se refiere al gran tamaño de los datos que se producen. Su inmenso tamaño es lo que los convierte en "Grandes" Datos. El volumen de datos que se produce hoy en día se mide en zettabytes (1 zettabyte = 1.000 millones de terabytes). El desarrollo de Internet, los smartphones y las tecnologías IoT han provocado un aumento exponencial del volumen de datos.

Velocidad

La velocidad se refiere al ritmo al que se generan nuevos datos. Con la llegada de las aplicaciones en tiempo real y los servicios de streaming, la velocidad de los datos ha cobrado mayor importancia. Cuanto más rápido se produzcan y procesen los datos, más valiosa será la información. En particular, la información en tiempo real puede ser muy valiosa para las aplicaciones sensibles al tiempo.

Variedad

La variedad se refiere a la diversidad de tipos de datos. Los datos pueden ser estructurados, semiestructurados o no estructurados, y el aumento de la variedad de fuentes de datos ha sido notable. La variedad de datos incluye desde datos numéricos estructurados en bases de datos tradicionales hasta documentos de texto no estructurados, correos electrónicos, vídeos, audios, datos de teletipos de bolsa y transacciones financieras.

Veracidad

La veracidad se refiere a la calidad o fiabilidad de los datos capturados. A medida que crece el volumen de datos, también pueden hacerlo las incoherencias, las ambigüedades y los desajustes en la calidad de los datos. Gestionar la veracidad de los datos es un reto, teniendo en cuenta la variedad de fuentes y tipos de datos. Depurar estos datos para obtener conjuntos de datos limpios y precisos para el análisis es un hito.

Estas 4 V representan claramente las características fundamentales de los Big Data. A continuación se presenta un resumen tabulado:

| V | Descripción |

|---|---|

| Volumen | Cantidad masiva de datos generados |

| Velocidad | Velocidad de generación y procesamiento de datos |

| Variedad | Tipos y fuentes de datos |

| Veracidad | Calidad y fiabilidad de los datos |

Las 4 V de Big Data se refieren a Volumen, Velocidad, Variedad y Veracidad, que son las características clave que definen los retos y oportunidades inherentes a Big Data. Estas características también representan los parámetros críticos que hay que tener en cuenta al tratar con herramientas y tecnologías de Big Data.

Por qué son importantes las 4 V en la gestión de Big Data

Entender las 4 V es imprescindible para comprender los retos asociados a la gestión de Big Data. Estas 4 V están interconectadas, y su gestión desempeña un papel fundamental a la hora de extraer información valiosa de los datos en bruto.

Por ejemplo, el gran "Volumen" convierte el almacenamiento en un reto, especialmente a alta "Velocidad". La "Variedad" masiva de datos, desde estructurados a no estructurados, aumenta la complejidad del procesamiento y el análisis. La "Veracidad" garantiza que los datos utilizados para el procesamiento y el análisis sean creíbles y fiables.

Una gestión eficaz de los Big Data requiere estrategias que puedan manejar las 4 V de forma eficiente. Gestionar el volumen requiere una solución de almacenamiento eficiente que no comprometa la potencia de procesamiento. Para hacer frente a la velocidad, se requiere una infraestructura flexible capaz de procesar los datos en tiempo real. El aumento de la variedad exige metodologías sofisticadas de procesamiento y gestión de datos que puedan manejar datos no estructurados. En cuanto a la veracidad, las técnicas de limpieza y filtrado de datos son fundamentales para eliminar el ruido y los errores de los datos.

La gestión de Big Data implica manejar las 4 V con eficacia para convertir los datos sin sentido en perspectivas valiosas. Las estrategias de datos exitosas deben abordar el alto volumen, gestionar la alta velocidad, procesar una variedad de tipos de datos y verificar la veracidad de los conjuntos de datos. Cada una de estas V plantea retos únicos, y su gestión eficaz es crucial para aprovechar el potencial de los Big Data.

Supongamos que una empresa de comercio electrónico quiere implantar un motor de recomendación. Para ello, necesita analizar los datos de comportamiento de sus usuarios. Es probable que estos datos tengan un gran Volumen, dado el número de usuarios y transacciones. Los datos también tendrán una gran Velocidad, ya que las interacciones de los usuarios se registran continuamente en tiempo real. La Variedad procederá de los distintos tipos de fuentes de datos: clics de los usuarios, historial de carritos, historial de transacciones, etc. La Veracidad adquiere importancia, ya que es necesario garantizar que los datos que se analizan son precisos y fiables.

Conocer bien estas 4 V y la interacción entre ellas puede ayudar a comprender no sólo cómo hacer frente al diluvio de Big Data, sino también cómo explotarlo en beneficio de la empresa. Permitiéndoles servir mejor a sus clientes, optimizar sus operaciones, crear nuevas fuentes de ingresos y mantenerse por delante de la competencia.

Big Data - Puntos clave

- Big Data se refiere a conjuntos de datos extremadamente grandes que son difíciles de procesar con los métodos tradicionales

- Los Big Data se caracterizan por su volumen (tamaño de los datos), velocidad (rapidez de generación y procesamiento de los datos) y variedad (diversas formas de datos).

- El término "Big Data" surge de un artículo de Erik Larson de 1989, que habla de cómo el aprovechamiento y la comprensión de grandes volúmenes de información, es decir, la recopilación, el almacenamiento y el procesamiento de datos, constituyen el núcleo de los Big Data

- Las tecnologías Big Data son las diversas herramientas y sistemas utilizados para capturar, almacenar, gestionar y procesar grandes cantidades de datos. Son conocidas por manejar la velocidad, el volumen y la variedad de los Big Data, al tiempo que extraen perspectivas significativas para añadir valor a las empresas o a la investigación.

- El Ingeniero de Big Data es un profesional responsable de diseñar, construir, probar y mantener sistemas de procesamiento de datos y bases de datos a gran escala. Son importantes en las empresas impulsadas por los datos, ya que manejan datos complejos, garantizan la integridad de los datos y mantienen la seguridad del sistema.

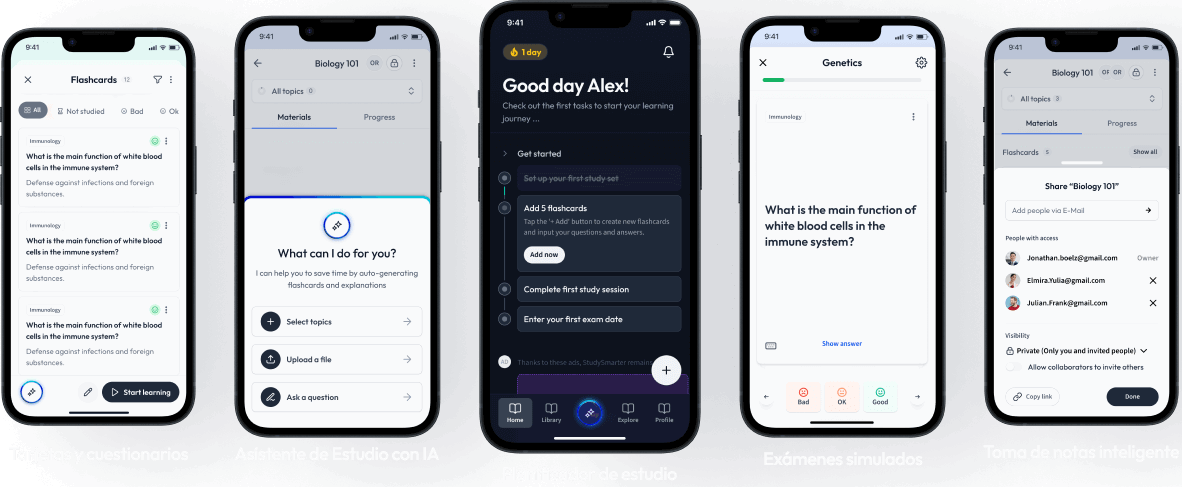

Aprende más rápido con las 384 tarjetas sobre Big Data

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Big Data

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más