Saltar a un capítulo clave

Introducción al Análisis de la Complejidad

El análisis de complejidad en informática es una faceta vital que ayuda a discernir la eficiencia de los algoritmos. Profundizando en el análisis de complejidad, adquieres una comprensión cuantitativa de los requisitos de velocidad y espaciado de tus operaciones, lo que te permite tomar decisiones informadas al escribir código.

¿Qué es el análisis de complejidad en informática?

En informática, el análisis de complejidad, también conocido como teoría de la complejidad computacional, es una evaluación teórica que mide los recursos computacionales que necesita un algoritmo para resolver un problema computacional. Los recursos computacionales que se suelen considerar durante el análisis de complejidad incluyen el tiempo (complejidad temporal) y el espacio (complejidad espacial).

La complejidad de un algoritmo se expresa normalmente utilizando la notación Big O.

Por ejemplo, si tienes un algoritmo que ordena una lista con "n" elementos, y se necesitan "n^2" operaciones para conseguirlo, expresarías la complejidad temporal como O(n^2).

Para comprender mejor el análisis de la complejidad, examinemos sus tipos:

- Complejidad temporal: Examina la cantidad total de tiempo que tarda en ejecutarse un algoritmo en función del tamaño de su entrada.

- Complejidad Espacial: Analiza la cantidad de memoria que utiliza un algoritmo en función del tamaño de su entrada.

La importancia del análisis de la complejidad de los algoritmos

Visualizar la eficacia de diversos algoritmos informáticos constituye el quid del análisis de la complejidad de los algoritmos. Se aprende a predeterminar el tiempo de ejecución o el espacio utilizado por un algoritmo en función del tamaño de los datos de entrada.

El análisis de la complejidad de los algoritmos es una herramienta importante que te permite comparar la eficacia de distintos algoritmos, optimizar el rendimiento de los algoritmos y hacer predicciones sobre las capacidades del hardware que se utiliza en la ejecución de los algoritmos.

Por ejemplo, supongamos que te enfrentas al reto de seleccionar un algoritmo para procesar una gran cantidad de datos. Al tener escasos conocimientos sobre el análisis de complejidad, podrías optar erróneamente por una solución que se ralentiza significativamente a medida que aumenta el tamaño de los datos. Conocer y comprender el análisis de complejidad te guiará en la selección de algoritmos altamente eficientes, mejorando la velocidad y el rendimiento del procesamiento de datos.

Realizar el análisis de complejidad de los algoritmos es muy importante, sobre todo en los casos en que se requiere un procesamiento de datos extenso, como en los motores de búsqueda, los sistemas de transacciones, el análisis de datos a gran escala, etc. La ignorancia o negligencia en el análisis de complejidad podría dar lugar a sistemas lentos e ineficaces, provocando así la insatisfacción del cliente.

En resumen, al diseñar e implantar algoritmos, es primordial comprender el análisis de complejidad, que te permitirá realizar compensaciones vitales entre tiempo y espacio, dando lugar a sistemas eficientes y escalables en rendimiento.

Comprender la complejidad temporal de los algoritmos

Un aspecto esencial del análisis de la complejidad en informática gira en torno a la complejidad temporal, un componente que explora el tiempo de ejecución de un algoritmo en función de las entradas. Abordar la complejidad temporal de los algoritmos requiere la comprensión de los conceptos básicos y las herramientas para su visualización. Esto te ayudará a comprender la rapidez o lentitud con que se ejecuta un algoritmo al aumentar las entradas.

Conceptos básicos de la complejidad temporal de los algoritmos

La complejidad temporal de un algoritmo cuantifica el tiempo que tarda en ejecutarse un algoritmo, en función de la longitud de la entrada. Mide el tiempo necesario para ejecutar cada sentencia de código de un algoritmo.

La complejidad temporal suele estimarse contando el número de operaciones elementales realizadas por el algoritmo, suponiendo que cada operación elemental tarda una cantidad fija de tiempo en realizarse. Por tanto, se considera que la cantidad de tiempo y el número de operaciones elementales realizadas por el algoritmo son proporcionales entre sí. Como tal, la complejidad temporal se expresa habitualmente utilizando la notación Big O.

| Notación | Nombre | Tiempo de ejecución |

|---|---|---|

| O(1) | Tiempo constante | El tiempo de ejecución es independiente del tamaño de la entrada |

| O(n) | Tiempo lineal | El tiempo de ejecución crece linealmente con el tamaño de la entrada |

| O(n^2) | Tiempo cuadrático | El tiempo de ejecución crece cuadráticamente con el tamaño de la entrada |

| O(log n) | Tiempo logarítmico | El tiempo de ejecución crece logarítmicamente con el tamaño de la entrada |

El objetivo del análisis de la complejidad temporal es conseguir una complejidad temporal baja para mejorar el rendimiento. Cuanto menor sea la complejidad temporal, más rápido se ejecutará el algoritmo. Conocer la complejidad temporal de tu algoritmo puede mejorar significativamente el rendimiento y la escalabilidad.

Por ejemplo, el recorrido de matrices tiene una complejidad temporal de O(n). Aquí, n se refiere al número total de elementos de la lista. Para entradas grandes, un algoritmo O(n) funciona mejor que un algoritmo O(n^2).

Una aplicación más compleja del análisis de la complejidad temporal consiste en escribir un código más rápido y eficiente, un aspecto crucial cuando se trabaja con cantidades importantes de datos, en el que tener un algoritmo robusto es mucho más impactante.

Análisis Visual de la Complejidad: Visualización de la Complejidad Temporal

Visualizar la complejidad temporal ayuda a comprender cómo crece el rendimiento de tus algoritmos al aumentar la entrada de datos. Aprovechando los modelos gráficos, es posible elegir con mayor discernimiento qué algoritmo utilizar para un tipo específico de entrada y qué impacto tendría su complejidad temporal en la eficiencia. Cuando graficas las complejidades temporales, obtienes una representación ilustrativa que revela cómo evolucionan con el tamaño de la entrada, y puedes anticipar cómo funcionarán tus algoritmos a escalas mayores.

Puedes crear un gráfico que muestre las complejidades temporales de algoritmos comunes. El eje x denota el tamaño de entrada "n" y el eje y representa el tiempo necesario para la ejecución. Ver estas curvas puede hacer más palpable cuánto mejor es una determinada complejidad temporal sobre otra a medida que 'n' se hace cada vez mayor.

Considera que tienes tres algoritmos A, B y C con complejidades temporales O(log n), O(n) y O(n^2) respectivamente. Si trazaras un gráfico para visualizar el crecimiento de estas complejidades temporales, podrías observar que para valores pequeños de n, quizá los tres algoritmos tengan un rendimiento similar. Sin embargo, a medida que n empieza a crecer, la diferencia entre ellos se hace cada vez más evidente. Descubrirías que el algoritmo A (O(log n)) funciona significativamente mejor que los demás, y que el algoritmo C (O(n^2)) crece tan rápido que rápidamente se vuelve irrealizable para entradas grandes.

Utilizando la complejidad temporal, puedes predecir el rendimiento y la escalabilidad de un algoritmo. Puede ayudarte a prepararte para entradas de datos de distintos tamaños y a elegir el algoritmo adecuado para el trabajo.

Explorar la complejidad espacial

La complejidad espacial es otra faceta crucial que descubres al sumergirte en el ámbito del análisis de la complejidad. Describe la cantidad de memoria que utiliza tu algoritmo en relación con el tamaño de la entrada que procesa. Al igual que la complejidad temporal, la gestión de la complejidad espacial de un algoritmo afecta a la eficacia y escalabilidad de tu programa.

El concepto básico de complejidad espacial

La complejidad espacial es una medida del espacio total de memoria que necesita un algoritmo para ejecutarse. Mide el espacio máximo necesario en cualquier momento de la ejecución del algoritmo, en función del tamaño de la entrada.

El rendimiento de un algoritmo no siempre se reduce al tiempo. La eficacia de un algoritmo también puede estar muy influida por la cantidad de memoria que utiliza el algoritmo. Por ello, comprender la complejidad espacial y ser capaz de calcularla con precisión es vital para el rendimiento general de un programa.

El espacio que necesita un algoritmo incluye tanto el espacio constante, que incluye espacio para variables simples, como el espacio variable necesario para estructuras complejas como colas, pilas y listas. Por tanto, la complejidad espacial de un algoritmo suele expresarse como la suma del espacio auxiliar, que es el espacio extra o el espacio temporal utilizado por un algoritmo, y el espacio utilizado por las variables de entrada o salida.

Es importante señalar aquí que, aunque la complejidad temporal suele ser una preocupación primordial, también debes pensar en conservar los recursos de memoria. En muchos casos prácticos, un algoritmo que utiliza menos memoria funciona de forma más eficiente, especialmente con entradas de datos más grandes. Dicho de otro modo, aunque un algoritmo sea menos rápido pero haga un uso óptimo del almacenamiento, en realidad puede ser muy superior a un algoritmo que sea marginalmente más rápido pero utilice una cantidad de memoria significativamente mayor.

Expresar la complejidad espacial es similar a expresar la complejidad temporal e implica el uso de la notación Big O. Por ejemplo:

- Si tu algoritmo es independiente del tamaño de la entrada con una utilización de memoria fija, generalmente se expresa como O(1), que representa una complejidad espacial constante.

- Si la memoria utilizada por tu algoritmo está relacionada linealmente con el tamaño de la entrada, suele expresarse como O(n), que representa una complejidad espacial lineal.

Por ejemplo, la complejidad espacial de un algoritmo sencillo que encuentra el mayor número de una lista sería O(n), donde "n" es el número de elementos de la lista. El razonamiento para ello es que la complejidad espacial incluye el espacio necesario para la entrada, y en este caso, tenemos que almacenar "n" elementos en la lista.

Análisis Visual Complejo: Representación de la complejidad espacial

Para desentrañar los entresijos de la complejidad espacial y comprender cómo se escala con el aumento del tamaño de la entrada, la visualización puede ser una herramienta increíblemente útil. Al crear representaciones visuales de la complejidad espacial, puedes ver de un vistazo cómo aumentan las demandas de memoria a medida que aumentan los datos de entrada y, en consecuencia, tomar decisiones más informadas a la hora de seleccionar e implementar algoritmos.

Un gráfico de complejidad espacial te ayuda a visualizar la correlación entre el tamaño del problema y el uso de memoria. Normalmente se representa gráficamente con el tamaño de la entrada en el eje x y el espacio necesario en el eje y. Esta comparación visual te permite deducir la eficacia del algoritmo en cuanto a la asignación y gestión de la memoria.

Consideremos dos algoritmos, X e Y. X tiene una complejidad espacial de O(n), mientras que Y tiene una complejidad espacial de O(1). Si trazas un gráfico de la complejidad espacial a medida que n aumenta, podrás ver fácilmente una diferencia cada vez mayor entre los dos algoritmos. La complejidad espacial del Algoritmo X aumentaría gradualmente en línea recta, demostrando un aumento progresivo de la memoria a medida que crece el tamaño de la entrada.

Por otro lado, el Algoritmo Y mostrará una línea recta horizontal, lo que implica que no aumenta el uso de memoria independientemente del tamaño de la entrada. Por lo tanto, para entradas más grandes, el Algoritmo Y demuestra una mayor eficiencia de memoria.

La comparación visual no sólo es estupenda para comprender qué algoritmo es mejor en términos de utilización de la memoria, sino que también proporciona una herramienta inestimable para prever cómo pueden cambiar las demandas del sistema a medida que crece el volumen de datos. Por tanto, te ayuda a diseñar el sistema y a predecir los requisitos de hardware para el futuro, ayudándote así a prever y planificar las actualizaciones de la infraestructura.

Técnicas avanzadas de análisis de la complejidad

A medida que profundizas en el análisis de la complejidad algorítmica, entran en juego algunas técnicas y consideraciones avanzadas. Éstas son esenciales para obtener una comprensión exhaustiva de las relaciones entre los algoritmos y sus métricas de eficiencia.

Reconocer los factores avanzados en el análisis de la complejidad

Al analizar la complejidad de los algoritmos, hay que tener en cuenta muchos factores además del tiempo y el espacio. Estos matices pueden influir enormemente en el rendimiento de los algoritmos dependiendo de su implementación, la naturaleza de los datos de entrada y los escenarios del mundo real. Comprender estos factores puede proporcionar información crucial sobre la eficacia general de los algoritmos.

Algunos de estos factores avanzados son la latencia, el rendimiento, la escalabilidad, las operaciones en serie y en paralelo, la disposición de los datos de entrada -ordenados, arbitrarios o aleatorios- y los tipos de datos -enteros, números en coma flotante, cadenas, etc.-.

En el contexto de la latencia, puedes tener algoritmos con baja latencia que funcionen muy rápidamente para conjuntos de datos pequeños, pero que pueden escalar mal debido a una complejidad temporal no óptima. Para gestionar mejor la latencia en las operaciones del mundo real, también es esencial conocer la complejidad temporal amortizada.

Considera un algoritmo de matriz dinámica que normalmente tarda un tiempo constante, O(1), en añadir un elemento. Sin embargo, cuando el búfer está lleno, añadir un elemento requiere reasignar un búfer mayor, copiar todos los elementos y puede llevar un tiempo O(n), donde n es el número actual de elementos. Aunque este caso pueda parecer una penalización grave, si implementas el algoritmo de forma que el tamaño del búfer se duplique cada vez que se llene, el coste de tiempo repartido entre las futuras anexiones resulta ser constante. Este ejemplo demuestra la comprensión de la complejidad temporal amortizada.

Además, a menudo los algoritmos se comportan de forma diferente en función de la disposición de sus datos de entrada. Un ejemplo clásico es el algoritmo "Quicksort", que muestra un comportamiento O(n^2) para datos ordenados o casi ordenados, pero se comporta eficientemente con O(nlogn) para datos aleatorios.

Otro factor predominante a tener en cuenta cuando se trata de análisis avanzados de complejidad es el rendimiento. Esto implica esencialmente que, al calcular la complejidad, tienes que tener en cuenta cuántas operaciones se producen en un mismo lapso de tiempo. Cuantas más operaciones por segundo, mayor será el rendimiento de la implementación.

Un ejemplo del mundo real sería el paradigma Mapreduce de Google. En este modelo, dividieron las tareas que tienen que manejar datos enormes en trozos pequeños y los procesaron en paralelo utilizando varias máquinas. Con ello, aumentaron el rendimiento del sistema.

Las operaciones secuenciales y concurrentes también desempeñan un papel en el análisis de la complejidad. Mientras que la complejidad temporal se refiere generalmente a las operaciones secuenciales, las operaciones concurrentes o paralelas pueden reducir significativamente la complejidad temporal.

Por último, pero no por ello menos importante, conocer los datos sobre los que operan tus algoritmos puede cambiar drásticamente su rendimiento. Si trabajas con números en coma flotante, ciertas operaciones matemáticas pueden tardar más que sus homólogas en números enteros, o la ordenación de cadenas puede requerir más comparaciones que la ordenación de números enteros.

Es vital tener en cuenta estas sutilezas y factores avanzados cuando realices análisis de complejidad de algoritmos. Abordarlos puede proporcionarte una comprensión y un manejo más personalizados y detallados del rendimiento y la escalabilidad de tu algoritmo.

Visualización del análisis de complejidad avanzado

Una comprensión exhaustiva del análisis de complejidad avanzado requiere la visualización de estos conceptos avanzados, añadiendo dimensiones adicionales a las visualizaciones de complejidad existentes en el tiempo y el espacio. Esto te ayuda a comprender mejor el rendimiento de los algoritmos en contextos variados.

Estas visualizaciones adicionales permiten comprender mejor el impacto de diversos factores en el rendimiento de los algoritmos. Las nuevas dimensiones que pueden añadirse a estos gráficos incluyen variables como la disposición de los datos, los tipos de datos y las operaciones paralelas frente a las secuenciales.

Por ejemplo, si estuvieras trazando la complejidad temporal de un algoritmo teniendo en cuenta también la disposición de las entradas, podrías utilizar distintos colores para representar los conjuntos de datos: aleatorios, ordenados y casi ordenados. Esto daría una idea visual de cómo funciona el algoritmo para disposiciones de datos variables.

En cuanto a las operaciones paralelas frente a las secuenciales, podrías representar el beneficio de las operaciones paralelas ajustando la complejidad temporal para que sea una fracción de la complejidad temporal secuencial, lo que daría un gráfico mixto.

Para dimensiones superiores, como la variación de los tipos de datos en las operaciones, se pueden utilizar trazados en 3D o múltiples trazados en 2D. Representan el tiempo que tardaría un algoritmo para números enteros, números en coma flotante o datos de cadena.

Un ejemplo de esto podría ser trazar gráficos diferentes para ordenar números enteros y ordenar cadenas para un algoritmo como "Ordenar por fusión". Comparando los dos, queda claro que la ordenación de números enteros es más rápida debido al menor número de operaciones necesarias en comparación.

Aparte de esto, también puedes trazar tiempos de preprocesamiento o gastos generales de memoria en visuales avanzados. Esto podría ser crucial para los algoritmos que dependen en gran medida de estrategias de precomputación o almacenamiento en caché.

Estas técnicas avanzadas de visualización proporcionan una comprensión global del grado de eficiencia de los distintos algoritmos en diversos escenarios. Empleando estas técnicas, puedes tomar decisiones más informadas a la hora de elegir el algoritmo más adecuado para tus necesidades específicas.

Aplicaciones prácticas del análisis de la complejidad

El análisis de complejidad, que tiene sus raíces en la informática teórica, se está aplicando ampliamente en numerosas aplicaciones prácticas, desde la consulta de bases de datos al aprendizaje automático. Se ha convertido en una herramienta esencial para hacer un uso eficiente de los recursos y mejorar el rendimiento general en estas aplicaciones. El análisis de complejidad te dota de la capacidad de hacer predicciones sobre el rendimiento futuro de tus algoritmos, lo que te ayuda en la planificación estratégica de recursos y actualizaciones de infraestructura.

Ejemplos reales de análisis de complejidad de algoritmos

El análisis de complejidad se realiza a diario en innumerables aplicaciones de numerosos sectores. Para ayudarte a comprender cómo se aplica en escenarios del mundo real, exploremos algunos ejemplos ilustrados.

Imagina un motor de búsqueda como Google. Cada consulta de búsqueda activa un algoritmo que debe cribar miles de millones de páginas web para presentarte los resultados más relevantes. La complejidad temporal de dicho algoritmo es de suma importancia, ya que los usuarios esperan respuestas rápidas. Incluso una pequeña optimización derivada de un análisis de complejidad puede proporcionar beneficios sustanciales a la escala de Google. Su paradigma MapReduce, por ejemplo, divide y conquista el procesamiento de grandes conjuntos de datos dividiéndolos y manejándolos concurrentemente, lo que produce una complejidad temporal más óptima.

Si volvemos la vista al sector financiero, pensemos en la negociación de alta frecuencia (HFT). Las empresas de HFT dependen en gran medida de algoritmos ultrarrápidos para realizar miles de operaciones en meras fracciones de segundo. La complejidad temporal de estos algoritmos afecta directamente a la cantidad de beneficios que se pueden obtener. Para mantener la latencia al mínimo, utilizan algoritmos de baja latencia, cuya complejidad temporal tiene una importancia significativa. Una menor complejidad temporal significa una ejecución más rápida y, por tanto, una mayor probabilidad de realizar operaciones rentables antes que el resto del mercado.

Pasando a las aplicaciones de encaminamiento de redes, los proveedores de servicios de Internet (ISP) gestionan enormes cantidades de datos que pasan por sus redes. Utilizan complejos algoritmos de encaminamiento para garantizar que los paquetes de datos lleguen a su destino de la forma más rápida y fiable posible. Se trata de algoritmos de búsqueda de grafos, cuya complejidad afecta a los vértices y aristas del grafo. El análisis de la complejidad guía la mejora de estos algoritmos, garantizando así una transferencia de datos más rápida y una mayor satisfacción del cliente.

Por último, si nos fijamos en las aplicaciones de aprendizaje automático, el entrenamiento de modelos de aprendizaje automático en grandes conjuntos de datos implica operaciones matemáticas complejas y puede requerir mucho tiempo y memoria. De ahí que la elección del algoritmo de aprendizaje y su complejidad desempeñen un papel primordial a la hora de determinar la rapidez con que puede entrenarse el modelo y utilizarse para hacer predicciones. Recorriendo este camino, el conocimiento de las complejidades temporales y espaciales de los distintos algoritmos de aprendizaje automático beneficia a la hora de elegir el más adecuado para la tarea en cuestión.

Estos ejemplos ilustran que conociendo y estimando la complejidad de nuestros algoritmos, se puede hacer más eficiente una amplia gama de aplicaciones del mundo real, abriendo la puerta a un rendimiento superior y a mejoras significativas en la experiencia del usuario.

El impacto del análisis de la complejidad en la eficiencia de los algoritmos

La eficiencia de los algoritmos es fundamental para el éxito de muchas aplicaciones de software, especialmente las que tratan con grandes cantidades de datos o requieren procesamiento en tiempo real. La eficiencia de un algoritmo puede clasificarse en dos grandes categorías: eficiencia temporal y eficiencia espacial. Y aquí es donde el análisis de la complejidad desempeña un papel importante. Ayuda a predecir cómo se escalarán los requisitos de tiempo y espacio de un algoritmo al aumentar el tamaño de la entrada.

La eficiencia temporal se refiere al tiempo de cálculo que tarda el algoritmo en realizar una tarea. Los algoritmos con menor complejidad temporal son, en general, más eficientes en el tiempo, ya que el tiempo que tardan en procesar los datos aumenta a un ritmo más lento con el aumento del tamaño de la entrada.

Por otro lado, la eficiencia espacial está relacionada con los requisitos de memoria del algoritmo. Se dice que un algoritmo es eficiente en el espacio si utiliza la memoria juiciosamente. Cuanta menos memoria utilice un algoritmo, más eficiente en el espacio será. La complejidad espacial es lo que te ayuda a comprender cómo crecerán los requisitos de memoria al aumentar el tamaño de la entrada.

Cuando se tiene en cuenta durante la fase de diseño e implementación, el análisis de la complejidad puede mejorar significativamente la eficiencia del algoritmo.

Por ejemplo, puedes optar por elegir un algoritmo con una mayor complejidad temporal pero una menor complejidad espacial si tu aplicación tiene unos recursos de memoria mínimos pero un tiempo de ejecución amplio. A la inversa, se puede elegir un algoritmo con mayor complejidad espacial pero menor complejidad temporal si la memoria no es una preocupación, pero el tiempo necesario para producir resultados es crítico.

Además, los modelos de complejidad pueden proporcionar información sobre el punto de inflexión en el que un algoritmo más complejo pero más rápido empieza a superar a otro menos complejo pero más lento. También pueden arrojar luz sobre la disposición de los datos y las operaciones paralelas, ayudando a optimizar el comportamiento de los algoritmos.

Así pues, los conocimientos del análisis de complejidad te permiten desarrollar y aplicar algoritmos optimizados para tus requisitos específicos, consiguiendo un rendimiento notablemente eficaz y una asignación de recursos juiciosa.

Análisis de complejidad - Puntos clave

El análisis de complejidad es un aspecto crucial de la informática, que ayuda a discernir la eficacia de los algoritmos cuantificando los requisitos de velocidad y espaciado de las operaciones.

El análisis de la complejidad mide los recursos computacionales que necesita un algoritmo para resolver un problema, sobre todo el tiempo (complejidad temporal) y el espacio de memoria (complejidad espacial).

La complejidad temporal examina la cantidad de tiempo que tarda en ejecutarse un algoritmo en función del tamaño de la entrada. Una menor complejidad temporal suele significar un rendimiento más rápido del algoritmo.

La complejidad espacial analiza cuánta memoria utiliza un algoritmo en relación con el tamaño de su entrada. Los algoritmos más eficientes suelen tener menor complejidad espacial.

Las técnicas de análisis visual de la complejidad ayudan a representar visualmente la complejidad temporal y espacial, ayudando a comprender la eficacia de los algoritmos y a predecir su rendimiento futuro.

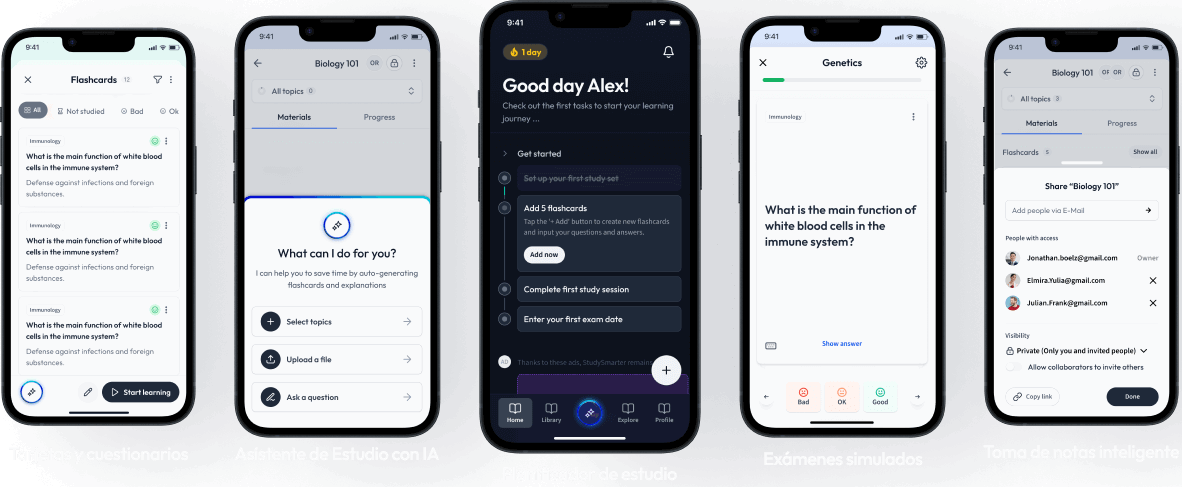

Aprende más rápido con las 15 tarjetas sobre Análisis de complejidad

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Análisis de complejidad

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más