Saltar a un capítulo clave

Descubre cómo el Análisis de Algoritmos fortalece la columna vertebral de las estructuras de datos, permitiendo operaciones más ágiles. Aventúrate en el Algoritmo de Análisis de Sentimiento, comprendiendo sus aspectos fundamentales y examinando fascinantes aplicaciones del mundo real. Aprecia cómo estos algoritmos interpretan y categorizan las emociones humanas captadas a partir de los datos. Por último, explora el dominio de los Algoritmos de Análisis de Big Data, reconociendo los esenciales y el papel crítico del Análisis de Algoritmos en la gestión de datos voluminosos. Observa cómo orquesta el orden en el caos de los grandes datos, transformándolos en valiosos conocimientos.

Entender el Análisis de Algoritmos

El Análisis de Algoritmos está en el corazón de la informática, sirviendo como un conjunto de herramientas que te permite evaluar y comparar el rendimiento de diferentes algoritmos en la resolución de tareas específicas. Al sumergirte en este tema, desarrollarás una aguda comprensión de cómo abordar complejos retos de codificación y desarrollar soluciones más eficientes.

Conceptos clave del análisis de algoritmos

Para empezar, es vital comprender las terminologías básicas que intervienen en el análisis de algoritmos.- Notación Big O: Esta notación describe un límite superior de la complejidad de un algoritmo. Proporciona una aproximación del tiempo máximo que tarda un algoritmo para todos los tamaños de entrada.

- Notación Ω Grande: Esta notación describe un límite inferior de la complejidad, determinando el tiempo mínimo requerido por un algoritmo.

- Notación Big Θ: Esta notación caracteriza los límites superior e inferior de la complejidad. Denota el comportamiento asintótico exacto.

- Análisis asintótico: Es el método para describir el comportamiento límite y suele estar estrechamente relacionado con las notaciones anteriores.

Las notaciones gran \(O\), gran \(\Omega\) y gran \(\Theta\) son herramientas analíticas utilizadas para describir la eficiencia de un algoritmo a medida que el tamaño de su entrada se aproxima al infinito.

Consideremos que tienes un algoritmo que, en el peor de los casos, ejecuta una proporción de pasos respecto al tamaño de su entrada (n) que puede representarse como 4n. Esto se expresaría como O(n) en notación big O, ya que en esta notación se ignoran las constantes de coeficiente. Del mismo modo, para los casos mejor y medio, utilizarías las notaciones big \(\Omega\) y big \(\Theta\) respectivamente.

Importancia del análisis de algoritmos en informática

El análisis de algoritmos desempeña un papel importante en la informática de varias maneras. Gracias a él puedes comprender mejor cómo optimizar el código y tomar decisiones informadas sobre el diseño de algoritmos.- Optimización del rendimiento: El análisis de la complejidad de los algoritmos te ayuda a hacer tu código más eficiente, reduciendo el tiempo y el espacio necesarios para ejecutar un programa.

- Escalabilidad: Al comprender el comportamiento de un algoritmo a medida que aumenta el tamaño de la entrada, puedes diseñar algoritmos que escalen bien con el tamaño del problema.

- Utilización de recursos: Los algoritmos eficientes utilizan menos recursos informáticos, incluida la potencia de procesamiento y la memoria.

- Mejor toma de decisiones: Permite una comparación más objetiva de distintos algoritmos y estructuras de datos en función de su eficiencia.

El análisis de algoritmos es el estudio de la complejidad computacional de los algoritmos. Ayuda a minimizar los recursos que necesita un programa, mejorando así la eficacia general del programa.

Gigantes de la industria como Google, Amazon y Facebook utilizan complejos algoritmos para dar servicio a miles de millones de usuarios diariamente. Una mejora marginal en uno de sus algoritmos, conseguida mediante un análisis y una optimización meticulosos, puede reducir significativamente los costes informáticos y mejorar la experiencia del usuario. Por eso, estas empresas invierten mucho en estudiar y perfeccionar continuamente sus algoritmos.

Explorando ejemplos de análisis de algoritmos

Profundizando en el mundo del Análisis de Algoritmos, puede ser beneficioso dilucidar algunos ejemplos que demuestren aplicaciones tanto básicas como avanzadas de estos conceptos. Este ejercicio te facilitará la identificación de los principios subyacentes cuando trabajes con situaciones del mundo real.

Ejemplos básicos de Análisis de Algoritmos

Ninguna discusión sobre el Análisis de Algoritmos puede considerarse completa sin una consideración exhaustiva de algunos ejemplos fundacionales. Estas implementaciones básicas proporcionarán una comprensión crujiente de los conceptos fundamentales implicados.

Considera la tarea de encontrar el número máximo en una matriz de números \( n \). Esta tarea puede realizarse utilizando un simple bucle para recorrer cada elemento de la matriz.

// Pseudocódigo para encontrar el número máximo de una matriz función encontrarMáx(matriz) { let max = matriz[0] FOR i = 1 to matriz.longitud - 1 DO IF matriz[i] > máx THEN máx = matriz[i] END IF END FOR return máx }En la notación Big O, esta función puede clasificarse como \( O(n) \) ya que la función se ejecuta una vez por cada elemento de la matriz. La complejidad aumentará linealmente con el tamaño de la matriz, ya que cada elemento se compara con el número máximo actual.

Por otro lado, un algoritmo para comprobar si un número es par o impar tendría el siguiente aspecto:

// Pseudocódigo para comprobar si un número es par o impar function isEvenOrOdd(number) { return (number % 2 == 0) ? 'Par' : 'Impar' }En este caso, el tiempo de ejecución de la función no depende del tamaño de la entrada, por lo que esta función tiene una complejidad temporal constante, clasificándola como \( O(1) \) en notación Big O.

Ejemplos de Análisis de Algoritmos en Aplicaciones del Mundo Real

Yendo más allá de lo básico, las aplicaciones del Análisis Algorítmico en el mundo real pueden encontrarse a menudo en diversos campos, como el procesamiento de bases de datos, la manipulación de imágenes e incluso la investigación genética.

Por ejemplo, considera los algoritmos de búsqueda utilizados por las bases de datos. La gestión eficiente de grandes bases de datos requiere el uso de algoritmos con una complejidad temporal logarítmica o sublogarítmica.

// Pseudocódigo de la búsqueda binaria function binarySearch(sortedArray, target) { let left = 0 let right = sortedArray.length - 1 WHILE left <= right DO let mid = left + (right - left) / 2 IF sortedArray[mid] == target THEN return mid ELSE IF sortedArray[mid] < target THEN left = mid + 1 ELSE right = mid - 1 END IF END WHILE return -1 }Los algoritmos de búsqueda binaria reducen el tamaño del problema a la mitad en cada paso, lo que lleva a una complejidad temporal de \( O(\log n) \), que se escala bien incluso para bases de datos muy grandes.

En el tratamiento de imágenes, sobre todo en los algoritmos de reconocimiento facial, se utiliza mucho el algoritmo de detección de Viola-Jones. Utiliza una cascada de clasificadores para rechazar las regiones no faciales de una imagen, reduciendo así el tiempo de cálculo.

Este algoritmo utiliza el concepto de "imagen integral", que permite calcular la suma de las intensidades de los píxeles dentro de una región rectangular en tiempo constante, independientemente del tamaño del rectángulo. Por tanto, en una imagen dada de tamaño \( m \times n \), la complejidad de cálculo de cada característica es \( O(1) \), y como cada región de una imagen puede tener unas \( 6000 \) características, la complejidad temporal en el peor de los casos pasa a ser \( O(6000mn) \). En notación Big O, ya que se ignoran las constantes, la complejidad temporal es \( O(mn) \).

Análisis de la complejidad de los algoritmos

El análisis de la complejidad de los algoritmos, un aspecto clave de la informática, es un método utilizado para determinar el rendimiento de los algoritmos en términos de tiempo y espacio. Proporciona una medida de los recursos que necesita un algoritmo a medida que crece el tamaño de la entrada. Esta medida cuantitativa es importante para comparar la eficacia de diferentes algoritmos, ayudando a seleccionar el que mejor responda a tus problemas computacionales.

Clasificación de la complejidad de los algoritmos

En el ámbito de la informática, la complejidad de un algoritmo puede clasificarse en dos categorías principales: Complejidad temporal y Complejidad espacial.

La Complejidad Temporal cuantifica la cantidad de tiempo que tarda en ejecutarse un algoritmo, en función del tamaño de la entrada del programa. Esencialmente, te permite comparar la velocidad a la que aumenta el tiempo de ejecución a medida que aumenta el tamaño de la entrada. Es importante señalar que no se trata del tiempo real, sino del número de operaciones que debe realizar el algoritmo.

Por otro lado, la Complejidad Espacial tiene que ver con la cantidad de espacio de memoria que necesita un algoritmo para ejecutarse. Viene determinada por dos factores: el espacio fijo o espacio necesario para almacenar determinados datos y variables (que es absolutamente necesario), y el espacio variable o espacio que necesitan las variables, dependiendo del tamaño del problema.

- Complejidad temporal: Refleja cómo escala el tiempo de ejecución de un algoritmo con el tamaño de la entrada. Las complejidades temporales pueden ser constante \((O(1))\), logarítmica \((O(\log(n)))\), lineal \((O(n))\), linealítmica ((O(n\log(n)))\), cuadrática ((O(n^2))\), cúbica ((O(n^3))\) y exponencial ((O(2^n))\), entre otras.

- Complejidad espacial: Se define por el espacio máximo de memoria que necesita el algoritmo para ejecutarse hasta el final. Al igual que la complejidad temporal, la complejidad espacial también puede ser constante, lineal o cuadrática.

Comprender la notación Big O en el análisis de la complejidad de los algoritmos

La notación Big O es una notación matemática que describe el comportamiento límite de una función. En informática, proporciona un límite superior de la complejidad temporal de un algoritmo, describiendo de hecho su peor escenario de rendimiento.

La notación Big O responde a la pregunta fundamental de "¿Cómo crece el tiempo de ejecución del algoritmo a medida que aumenta el tamaño de la entrada?".

Varios ejemplos de complejidad temporal utilizando la notación Big O son:

\(O(1)\) o Complejidad Temporal Constante: El tiempo de ejecución permanece constante a medida que aumenta el tamaño de la entrada.

\(O(n)\) o Complejidad Temporal Lineal: El tiempo de ejecución aumenta linealmente con el tamaño de la entrada.

\O(O(n^2)\) o Complejidad cuadrática del tiempo: El tiempo de ejecución aumenta cuadráticamente con el tamaño de la entrada.

\O(O(\log n)\) o Complejidad de tiempo logarítmica: El tiempo de ejecución aumenta logarítmicamente con el tamaño de la entrada.

Si un algoritmo tiene una complejidad temporal de \(O(n^2)\), como Bubble Sort, se volverá lento rápidamente para grandes conjuntos de datos. Sin embargo, un algoritmo con una complejidad temporal de \(O(\log n)\), como la Búsqueda Binaria, manejará conjuntos más grandes con mucha más eficacia.

La notación \(O(n)\) describe una salida que cambia linealmente a medida que cambia la entrada, mientras que la notación \(O(n^2)\) representa una salida que cambia cuadráticamente a medida que cambia la entrada. La notación \(O(\log n)\), sin embargo, implica que la salida cambia logarítmicamente con el cambio de la entrada.

Comprender la notación Big O es de suma importancia porque te permite evaluar la tasa de crecimiento a largo plazo del tiempo de ejecución de un algoritmo. Este conocimiento te ayuda a elaborar programas eficientes e incluso puede ayudarte a determinar la viabilidad de un problema computacional.

Análisis de algoritmos en estructuras de datos

Cuando se trata de estructuras de datos, el análisis de algoritmos es una herramienta inestimable para garantizar su eficacia. Ayuda a decidir la estructura de datos más adecuada para tareas específicas, proporcionando una visión de la complejidad temporal y espacial de las distintas operaciones. El uso eficiente de las estructuras de datos puede mejorar drásticamente la velocidad y el rendimiento de un algoritmo y, por tanto, del propio software en general.

Análisis de algoritmos en estructuras de datos de matrices

Una matriz es una de las estructuras de datos más básicas y potentes de la informática. Es un contenedor que puede albergar un número fijo de elementos, y estos elementos deben ser del mismo tipo. En el contexto del análisis de algoritmos, las matrices suelen ser objeto de numerosas evaluaciones interesantes.

Cuando se utilizan matrices, ciertas operaciones como acceder a un elemento, actualizar un elemento o asignar un elemento pueden hacerse en tiempo constante, es decir, \(O(1)\). Sin embargo, otras operaciones como buscar, insertar o borrar pueden variar considerablemente su complejidad temporal en función de la posición del elemento objetivo y del tamaño de la matriz. Por ejemplo, insertar un nuevo elemento en una matriz completa requiere reasignar la matriz, lo que tiene una complejidad temporal de \(O(n)\), donde \(n\) es el número de elementos de la matriz.

Pongamos por ejemplo que intentas encontrar un elemento concreto en una matriz sin ordenar. En el peor de los casos, tendrías que buscar en todos los elementos de la matriz antes de encontrar el que quieres, o no encontrarlo en absoluto. Así que la complejidad temporal de esta operación es \(O(n)\).

La complejidad espacial de una matriz es directamente proporcional a su tamaño. Si una matriz puede contener \(n\) elementos, ocupa \(n\) unidades de espacio. Por tanto, podemos decir que la complejidad espacial de una matriz es \(O(n)\).

En resumen, aunque las matrices proporcionan un acceso rápido a sus elementos, las operaciones con matrices, como insertar y eliminar, son relativamente lentas e ineficaces, a menos que el elemento se encuentre al final de la matriz. Además, las matrices tienen un tamaño fijo, lo que puede repercutir negativamente en la complejidad espacial si no se manejan con cuidado.

Importancia del Análisis de Algoritmos en la Organización de Datos

El Análisis de Algoritmos y la organización de datos son conceptos entrelazados en el campo de la informática. Una estructura de datos bien organizada puede dar lugar a algoritmos más eficientes, lo que es vital para gestionar grandes cantidades de datos, como bases de datos y aplicaciones de big data.

Una organización eficiente de los datos almacena la información de forma que se minimizan las complejidades temporales y espaciales de las operaciones sobre esos datos. Cuanto mejor entiendas tus algoritmos, más podrás optimizar tu organización de datos para estas operaciones.

El hashing es una ilustración excelente de este concepto. Es un método para almacenar datos que permite operaciones de búsqueda y recuperación casi instantáneas. La función hash toma una clave, realiza un cálculo y devuelve una ubicación de índice donde se puede encontrar el valor.

El análisis de los algoritmos hash se ocupa de las estrategias de resolución de colisiones, como el sondeo lineal, el sondeo cuadrático o el doble hashing, y de su impacto en la complejidad temporal. Una función hash bien diseñada con una resolución de colisiones eficiente puede dar lugar a tiempos de búsqueda extremadamente bajos, lo que es esencial para muchas aplicaciones.

Por ejemplo, considera una aplicación de agenda telefónica que utilice una tabla hash para almacenar los contactos. Si se diseña adecuadamente, puede recuperar cualquier información de contacto en un tiempo casi constante, es decir, \(O(1)\), independientemente del tamaño de la agenda. Sin embargo, si la función hash y la resolución de colisiones no están bien diseñadas, podría producirse un número significativo de colisiones, lo que ralentizaría la operación de búsqueda y aumentaría la complejidad temporal.

Comprender el análisis de algoritmos nos permite elegir estructuras de datos adecuadas en función de la naturaleza de las operaciones y del tamaño de los datos. Para las operaciones que requieren un acceso rápido en tiempo constante, una tabla hash podría ser ideal. Sin embargo, para otras que requieran datos ordenados o una búsqueda eficiente de mínimo/máximo, podría ser más adecuado un árbol de búsqueda equilibrado.

En conclusión, un conocimiento profundo del análisis de algoritmos te llevará a elaborar soluciones eficaces para organizar, procesar y gestionar datos. Es una habilidad inestimable para todo aspirante a informático y profesional experimentado, que influye en el rendimiento y la usabilidad de tu software, aplicaciones o sistemas.

Algoritmo de Análisis de Sentimiento

Adentrándonos en el fascinante mundo del Procesamiento del Lenguaje Natural (PLN), se nos presenta una intrincada y poderosa herramienta conocida como Análisis de Sentimientos. Como estudio computacional de los sentimientos, opiniones y actitudes de las personas expresados en datos textuales, los Algoritmos de Análisis de Sentimiento han revolucionado nuestra capacidad de interpretar y analizar datos textuales a gran escala.

Conceptos básicos del Algoritmo de Análisis de Sentimiento

En esencia, el Análisis de Sentimiento consiste en determinar el tono emocional oculto tras las palabras. Esto resulta crucial en la monitorización de las redes sociales, ya que te permite rastrear el estado de ánimo del público ante una marca o un producto concretos. La naturaleza inherente de su análisis cualitativo podría conducir a percepciones que podrían ser inestimables para una gestión reactiva de la marca.

Tradicionalmente, los algoritmos de análisis de sentimientos son de tres tipos:

- Sistemasbasados en reglas que realizan el análisis de sentimientos a partir de un conjunto de reglas elaboradas manualmente.

- Sistemasautomáticos que se basan en técnicas de aprendizaje automático para aprender de los datos.

- Sistemas híbridos que combinan enfoques basados en reglas y automáticos.

Un sistema basado en reglas funciona utilizando un conjunto de reglas o heurísticas predefinidas, mientras que un sistema automático utiliza técnicas de aprendizaje automático para aprender de los datos y hacer predicciones. Los sistemas híbridos combinan lo mejor de ambos enfoques y están equipados para manejar una mayor variedad de tareas.

Los Algoritmos de Análisis de Sentimiento pueden profundizar para comprender el contexto. Además de la clasificación binaria básica de positivo o negativo, pueden proporcionar resultados de grano más fino, como muy negativo, negativo, neutro, positivo y muy positivo. Este tipo de análisis de sentimientos también se conoce como análisis de sentimientos de grano fino.

Ilustremos esto con un fragmento de código de un Algoritmo de Análisis de Sentimiento básico utilizando el Kit de Herramientas de Lenguaje Natural de Python (NLTK).

// Pseudocódigo de un algoritmo básico de análisis de sentimientos import nltk from nltk.sentiment import SentimentIntensityAnalyzer // Crea una instancia de SentimentIntensityAnalyzer sia = SentimentIntensityAnalyzer() // Tomemos un texto de ejemplo text = "Python es el mejor lenguaje de programación" // Analiza el sentimiento del texto sentiment = sia.polarity_scores(text) // Imprime las puntuaciones de sentimiento print(sentiment)La salida de la puntuación del sentimiento será un valor de diccionario que mostrará los sentimientos positivo, negativo, neutro y compuesto. El método integrado polarity_scores calcula estas puntuaciones de sentimiento basándose en un conjunto de características léxicas. El valor compuesto es una puntuación que calcula la suma de todas las valoraciones léxicas que se han normalizado para que oscilen entre -1 y 1, donde 1 significa un sentimiento altamente positivo y -1 un sentimiento altamente negativo.

Aplicaciones del Algoritmo de Análisis de Sentimiento en el Mundo Real

En la era digital actual, en la que los datos se componen en gran parte de texto, el Análisis de Sentimiento es una herramienta clave para extraer información de la gran cantidad de datos disponibles. La monitorización de redes sociales, la monitorización de marcas, la voz del cliente (VoC), el servicio de atención al cliente, la investigación de mercados y el análisis de la fuerza de trabajo son sólo algunas de las áreas en las que los algoritmos de sentimiento desempeñan un papel importante.

Por ejemplo, en la monitorización de redes sociales, el análisis de sentimientos se utiliza para extraer y escudriñar el contenido generado por los usuarios, como actualizaciones de estado, comentarios y reseñas, para extraer información sobre la opinión pública de un producto, servicio, evento o marca. Del mismo modo, en el servicio de atención al cliente, puede proporcionar información sobre los sentimientos de los clientes respecto al servicio que han recibido, lo que permite a las empresas mejorar y personalizar su servicio.

Imagina que una empresa lanza un nuevo producto y quiere medir la respuesta del público al mismo. Podrían utilizar el análisis de sentimiento en las publicaciones, reseñas y comentarios de las redes sociales para determinar si la recepción del producto es mayoritariamente positiva o negativa. Además, podrían identificar puntos de dolor o características deseadas que podrían incorporar en futuras iteraciones del producto.

Aunque llevar a cabo un análisis de sentimientos a gran escala requiere tratar con un enorme volumen de datos y complicadas construcciones de lenguaje natural, los conocimientos que se pueden obtener son inestimables para muchos sectores.

Desde comprender la opinión pública hasta reconocer la satisfacción del cliente y ajustar las estrategias de marketing en consecuencia, los algoritmos de análisis de sentimientos ofrecen una ventana a las emociones y actitudes de las masas. Abre posibilidades para una gestión activa y receptiva de la marca, manteniendo a las empresas al corriente de cómo se perciben y reciben sus acciones y productos, suscitando conversaciones y profundizando su conexión con el público.

Algoritmos de análisis de Big Data

Cuando se trabaja con cantidades colosales de datos, lo que se conoce como Big Data, los métodos convencionales de procesamiento de datos a menudo se quedan cortos. Para manejar eficazmente los Big Data, necesitas algoritmos especializados capaces de procesar, analizar y extraer información significativa de vastos conjuntos de datos con eficacia. Estos Algoritmos de Análisis de Big Data están diseñados para gestionar datos demasiado grandes, complejos y dinámicos para los sistemas convencionales.

Algoritmos esenciales de análisis de Big Data

A lo largo del tiempo han surgido varios algoritmos de análisis de Big Data, cada uno con sus propios puntos fuertes y adecuados para abordar distintos tipos de problemas. Aprender estos algoritmos te proporciona una serie de herramientas que puedes aplicar para manejar diversos escenarios de Big Data de forma competente.

- MapReduce: MapReduce es un modelo de programación utilizado para procesar y generar grandes conjuntos de datos con un algoritmo paralelo y distribuido en un clúster. Un programa MapReduce se compone de un procedimiento Map() que realiza el filtrado y la ordenación, y un procedimiento Reduce() que realiza una operación de resumen.

- Algoritmos de aprendizaje automático: Abarcan un sinfín de algoritmos de aprendizaje supervisado y no supervisado, como la regresión lineal, la regresión logística, los árboles de decisión, los bosques aleatorios y los algoritmos de agrupación. Los algoritmos de aprendizaje automático son ideales para hacer predicciones e identificar patrones en Big Data.

- Algoritmos de grafos: Estos algoritmos están diseñados para analizar las relaciones entre entidades. Son útiles en el análisis de redes sociales, sistemas de recomendación y motores de búsqueda. PageRank, utilizado por Google, es un ejemplo bien conocido de algoritmo de grafos.

- Apache Hadoop y Apache Spark: Ambos son marcos de código abierto que permiten el procesamiento distribuido de grandes conjuntos de datos a través de clústeres de ordenadores. Mientras que Hadoop MapReduce es un marco de cálculo basado en disco, Spark ofrece un marco de cálculo en memoria que aumenta significativamente la velocidad de ejecución.

- Apriori: Es un algoritmo muy utilizado en el análisis de la cesta de la compra para aprender reglas de asociación. Construye un árbol hash de conjuntos de elementos para contar el soporte de cada elemento de forma eficiente. La propiedad Apriori establece que todos los subconjuntos no vacíos de un conjunto de elementos frecuentes también deben ser frecuentes.

Por ejemplo, una empresa de comercio electrónico puede utilizar el algoritmo Apriori para conocer el comportamiento de compra de sus clientes. Al descubrir qué conjuntos de productos se compran juntos con frecuencia, la empresa puede elaborar estrategias de colocación de productos y recomendaciones para aumentar las ventas.

Papel del Análisis de Algoritmos en la Gestión de Big Data

El análisis de algoritmos desempeña un papel fundamental en la gestión de Big Data. Estos enormes conjuntos de datos pueden ser increíblemente difíciles de manejar y puede suponer todo un reto procesarlos, analizarlos y recuperar información significativa de ellos en un plazo de tiempo razonable. Por lo tanto, es importante analizar la eficacia y el rendimiento de los algoritmos que se emplean para abordar el Big Data.

- Mejora del rendimiento: El uso de algoritmos eficientes optimizados para Big Data puede reducir drásticamente el tiempo necesario para el procesamiento y el análisis. Comprendiendo la complejidad computacional e identificando las ineficiencias de un algoritmo, se pueden introducir mejoras eficaces.

- Escalabilidad: A medida que crece el tamaño de los datos, los algoritmos deben ser capaces de seguir el ritmo. El análisis de algoritmos puede ayudar a garantizar que tus algoritmos escalen eficazmente a medida que crecen tus datos.

- Garantía de calidad de los datos: Los algoritmos eficientes también pueden ayudar a mantener la calidad de los datos, identificando y corrigiendo rápidamente errores o incoherencias en los datos.

- Gestión de recursos: Los algoritmos eficientes también pueden ayudar a reducir los recursos computacionales necesarios. En última instancia, esto puede suponer un ahorro de costes, especialmente cuando se trata de Big Data.

Imagina una empresa de telecomunicaciones que analiza sus registros detallados de llamadas (CDR) para detectar fraudes. Con millones de llamadas realizadas cada día, el tamaño de los datos puede ser enorme. Los algoritmos ineficaces podrían tardar días en realizar el análisis, y para cuando se identifique cualquier actividad fraudulenta, el daño podría estar ya hecho. Sin embargo, con un algoritmo eficiente, el mismo análisis podría realizarse en tiempo real, identificando y previniendo rápidamente las actividades fraudulentas.

En última instancia, comprender tus algoritmos de análisis de Big Data, sus complejidades temporales y espaciales, y sus puntos fuertes y débiles, puede mejorar enormemente tu capacidad para obtener información significativa y procesable de tus datos de forma eficiente, eficaz y rápida.

Análisis de algoritmos - Puntos clave

El Análisis de Algoritmos es un aspecto fundamental de la informática, que te permite evaluar y comparar el rendimiento de diferentes algoritmos en la resolución de tareas específicas.

La complejidad de los algoritmos puede clasificarse en dos tipos: Complejidad temporal y Complejidad espacial.

La Notación Big O es una notación matemática utilizada en el análisis de algoritmos para proporcionar una aproximación del tiempo máximo que tarda un algoritmo para todos los tamaños de entrada.

El análisis de algoritmos en estructuras de datos es importante para evaluar la complejidad temporal y espacial de distintas operaciones y ayuda en la toma de decisiones para la selección de la estructura de datos más adecuada.

Análisis de Sentimientos Los algoritmos del campo del Procesamiento del Lenguaje Natural interpretan y categorizan las emociones humanas captadas a partir de los datos.

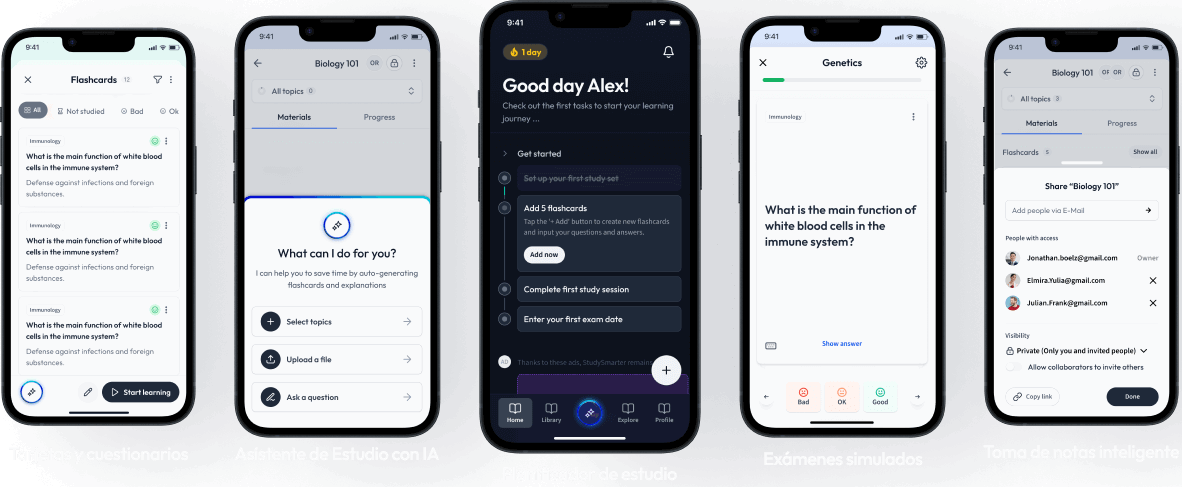

Aprende más rápido con las 18 tarjetas sobre Análisis de algoritmos

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Análisis de algoritmos

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más