Saltar a un capítulo clave

Algoritmos de codificación: definición y objetivo

Los algoritmos de codificación son procesos sistemáticos que transforman un conjunto de datos de entrada en un formato que se ajusta a ciertos criterios, como compresión o encriptación. Su objetivo principal es asegurar que los datos puedan ser transmitidos, almacenados o procesados de manera eficiente y segura. Estos algoritmos son fundamentales en diversas aplicaciones, incluyendo telecomunicaciones, informática y ciberseguridad. Comprender su funcionamiento es crucial para mejorar la eficiencia y reducir los riesgos asociados con la gestión de datos.

Tipos de algoritmos de codificación

Existen diferentes tipos de algoritmos de codificación que se utilizan en función del propósito deseado. Algunos de los más comunes son:

- Codificación de fuente: Se utiliza para reducir el tamaño de los datos antes de su almacenamiento o transmisión. Ejemplos incluyen la compresión de archivos JPEG o MP3.

- Codificación de canal: Protege los datos contra errores que puedan ocurrir durante la transmisión. Ejemplos incluyen códigos Hamming y Reed-Solomon.

- Codificación de línea: Prepara los datos para la transmisión en un medio físico, asegurando que las propiedades del canal se mantengan. Ejemplo: Manchester encoding.

- Codificación de seguridad: Transforma datos para prevenir el acceso no autorizado, como se ve en la encriptación AES o RSA.

Algoritmos de codificación: Procesos que transforman datos en un formato adecuado para su almacenamiento, transmisión o procesamiento.

Ejemplo de codificación de seguridad: Imagina que tienes un mensaje secreto que deseas enviar por correo electrónico. Utilizas el algoritmo de encriptación AES para convertir tu mensaje en código cifrado que solo puede ser decodificado por una persona que tenga la clave secreta.

¿Sabías que la compresión de datos puede reducir significativamente el espacio de almacenamiento y el ancho de banda requerido para la transmisión?

Los algoritmos de codificación han avanzado increíblemente desde los primeros días de la computación. Hoy en día, los algoritmos de compresión como Huffman y LZW son utilizados para comprimir textos de manera eficiente. Estos algoritmos minimizan la redundancia en los datos, haciéndolos más compactos. La codificación en la comunicación digital ha sido revolucionaria, permitiendo velocidad y precisión en la transmisión de grandes volúmenes de información. En el mundo actual, donde el intercambio de información es omnipresente, el continuo desarrollo de los algoritmos de codificación juega un papel vital en la ciberseguridad, asegurando que solo los destinatarios previstos puedan acceder a la información.

Tipos de algoritmos de codificación

Al abordar el tema de los algoritmos de codificación, es importante entender los diferentes tipos que existen y cómo se aplican en situaciones específicas. Estos algoritmos son herramientas esenciales en la informática moderna y desempeñan un rol crucial en la gestión y protección de datos.

Codificación de fuente

La codificación de fuente se centra en reducir el tamaño de los datos para su almacenamiento o transmisión. Se puede realizar mediante algoritmos de compresión sin pérdidas como Huffman, que reestructuran los datos sin perder información. Por otro lado, algoritmos de compresión con pérdidas como MP3 y JPEG sacrifican ciertos detalles para lograr una mayor reducción del tamaño. La fórmula básica utilizada en la codificación de fuente para evaluar la eficiencia es la entropía, definida como: \[ H(X) = - \sum_{i=1}^{n}p(x_i)log_b(p(x_i)) \] donde \( p(x_i) \) representa la probabilidad de cada símbolo en la fuente.

Un ejemplo popular de codificación de fuente es el algoritmo JPEG para la compresión de imágenes. Utiliza transformadas para convertir la imagen en información de frecuencia y descarta datos que el ojo humano no percibe fácilmente. Como resultado, las imágenes se comprimen significativamente sin una pérdida notable de calidad.

Codificación de canal

La codificación de canal se utiliza para proteger los datos contra errores durante la transmisión. Los algoritmos como los códigos Hamming y Reed-Solomon son ejemplos prominentes.Un aspecto clave es la capacidad de estos algoritmos para detectar y corregir errores mediante la adición de bits de redundancia, por ejemplo, usando bit de paridad. La fórmula clásica para calcular el bit de paridad es: \[ P = \bigoplus_{i=1}^{n}b_i \] donde \( b_i \) son los bits de datos y \( \bigoplus \) representa la operación OR exclusiva (XOR).

Los códigos Reed-Solomon son ampliamente utilizados en tecnologías como CDs, DVDs y datos de transmisión satelital. Este método emplea la teoría óptima de la corrección de errores usando el concepto de polinomios en un campo finito. Por ejemplo, se transforma un bloque de datos en un polinomio y se añade redundancia para corregir errores durante la transmisión. Reed-Solomon es famoso por su habilidad para corregir múltiples errores por bloque, lo que lo hace extremadamente confiable.

Codificación de línea

La codificación de línea es responsable de convertir datos digitales en señales adecuadas para ser transmitidas a través de un medio físico, como cables de cobre o fibra óptica.Un famoso método es la codificación Manchester, que se utiliza en estándares como Ethernet. Cada bit de datos se codifica en dos bits de señal, garantizando que el receptor pueda recuperar el reloj y los datos de la señal recibida.En términos matemáticos, se representa como una secuencia de alternancia entre niveles altos y bajos, haciendo que la suma de niveles por cada símbolo sea igual a cero, reduciendo la componente de DC. El propósito es mantener sincronicidad en la señal.

La sincronización es clave en la codificación de línea. Sin ella, la transmisión de datos entre dispositivos fallaría.

Codificación de seguridad

Los algoritmos de codificación de seguridad, más conocidos como algoritmos de encriptación, transforman los datos para protegerlos del acceso no autorizado. Métodos como AES (Advanced Encryption Standard) y RSA son ampliamente utilizados en el cifrado de datos digitales. La encriptación utiliza claves, y su seguridad se basa en la complejidad matemática de invocar operaciones inversas sin conocer la clave. Por ejemplo, el RSA se basa en la dificultad de factorizar números muy grandes, y se representa de forma matemática como: \[ c = m^e \bmod n \] donde \( c \) es el texto cifrado, \( m \) es el texto original, \( e \) es el exponente de la clave pública, y \( n \) es el producto de dos números primos.

Algoritmo de codificación de Huffman

El algoritmo de codificación de Huffman es un método de compresión sin pérdida que se utiliza para reducir el tamaño de los datos. Se basa en la frecuencia de aparición de cada símbolo en el conjunto de datos, asignando códigos más cortos a los símbolos más frecuentes y códigos más largos a los menos comunes. Esto permite una eficiente representación de los datos sin perder información.El algoritmo construye un árbol binario donde cada hoja representa un símbolo del conjunto, y el camino desde la raíz hasta cada hoja proporciona el código correspondiente al símbolo. Este proceso resulta en una compresión óptima, y es ampliamente utilizado en diversas aplicaciones de compresión de datos.

La codificación de Huffman es un algoritmo de compresión sin pérdida que crea códigos de longitud variable basados en la frecuencia de los símbolos.

Funcionamiento del algoritmo de Huffman

El algoritmo de Huffman trabaja construyendo un árbol de codificación mediante los siguientes pasos:

- Calcular la frecuencia de cada símbolo en el conjunto de datos.

- Ordenar los símbolos en una cola de prioridad basada en sus frecuencias.

- Combinar los dos nodos de menor frecuencia para crear un nodo padre con una frecuencia igual a la suma de los dos nodos.

- Repetir el proceso hasta que solo quede un nodo, que se convierte en la raíz del árbol de Huffman.

- Asignar códigos binarios a cada símbolo recorriendo el árbol desde la raíz hasta cada hoja.

Considera un conjunto de datos simple con símbolos y frecuencias:

| A | 45 |

| B | 13 |

| C | 12 |

| D | 16 |

| E | 9 |

| F | 5 |

- (F, 5) y (E, 9) ➞ combinan en (FE, 14)

- (FE, 14) y (C, 12) ➞ combinan en (FEC, 26)

- (B, 13) y (D, 16) ➞ combinan en (BD, 29)

- (FEC, 26) y (BD, 29) ➞ combinan en (FECBD, 55)

- Finalmente, (A, 45) y (FECBD, 55) ➞ combinan en la raíz (A+FECBD, 100)

El algoritmo de Huffman siempre produce el resultado óptimo cuando se trata de compresión sin pérdida.

La codificación de Huffman se originó en 1952 por David A. Huffman como parte de una tesis universitaria. Se ha convertido en uno de los algoritmos más eficaces y comprensibles en la teoría de la información y compresión de datos. Hoy en día, es una parte fundamental de muchas utilidades de compresión como ZIP y en formatos multimedia como JPEG para imágenes y MP3 para audio.En aplicaciones prácticas, una variación del algoritmo básico de Huffman, llamada codificación a dos pasos o Huffman adaptativo, se usa para cases cuando las frecuencias de símbolo son desconocidas o cambian con el tiempo. Además, aunque es óptimo para símbolos únicos, no siempre es el mejor para conjuntos de símbolos más complejos, donde técnicas avanzadas como el codificación aritmética pueden superar a Huffman en la compresión.

Algoritmo de codificación de Lempel-Ziv

El algoritmo de Lempel-Ziv es uno de los métodos más utilizados para la compresión de datos. Se basa en la idea de reemplazar las ocurrencias repetidas de cadenas de caracteres con referencias más cortas a una entrada anterior de la misma cadena. Este método de compresión sin pérdida permite una significativa reducción del tamaño de los datos.

Algoritmos de compresión de datos

Los algoritmos de compresión de datos utilizan distintas técnicas para reducir el tamaño de los datos. Existen principalmente dos tipos: la compresión con pérdida y la compresión sin pérdida.

- Compresión con pérdida: Este tipo reduce el tamaño del archivo eliminando detalles insignificantes, como se observa en el formato JPEG para imágenes.

- Compresión sin pérdida: Permite recuperar exactamente los datos originales. Ejemplos conocidos son los formatos ZIP y los métodos de compresión de tipo Lempel-Ziv.

Tomemos como ejemplo una cadena de texto: 'ABABABAB'. Un algoritmo de compresión de tipo Lempel-Ziv podría codificarlo como 'AB(0,5)', indicando que después del primer 'AB', la cadena repetida comienza de la posición 0 y tiene una longitud de 5 caracteres.

La mayoría de los algoritmos de compresión utilizados en la actualidad, como ZIP y GIF, se basan en el algoritmo Lempel-Ziv.

El algoritmo de Lempel-Ziv-Welch (LZW), una modificación del original, se ha hecho especialmente popular por su simplicidad y eficacia en la compresión de datos. A diferencia del Lempel-Ziv básico, LZW construye su tabla de frases dinámicamente durante el proceso, eliminando la necesidad de una fase de entrenamiento inicial. El método LZW ha encontrado aplicaciones en el formato de imagen GIF y en el sistema de archivos UNIX 'compress'.Desde el punto de vista matemático, la codificación LZW crea una correspondencia a uno de entre un conjunto finito de palabras o frases existentes dentro del texto a medida que se procesa. Utiliza diccionarios tanto predefinidos como de codificación dinámica para lograr la compresión, almacenando referencias para facilitar una rápida decodificación.

Aplicaciones de la codificación en ingeniería

La codificación desempeña un papel crucial en la ingeniería, ya que permite la optimización de recursos y la mejora del rendimiento en múltiples aplicaciones.

- Transmisión de datos: En las telecomunicaciones, la compresión de datos reduce la carga en los canales de transmisión, permitiendo que más datos se transmitan simultáneamente.

- Almacenamiento: La compresión eficaz de datos permite el almacenamiento de grandes volúmenes de información en dispositivos de capacidad limitada.

- Ciberseguridad: Algoritmos de codificación protegen los datos al aplicar técnicas de cifrado, asegurando que solo los destinatarios previstos puedan acceder a la información.

- Procesamiento de señal: En procesamiento de señales, los métodos de codificación optimizan el uso de ancho de banda y reducen las interferencias.

algoritmos de codificación - Puntos clave

- Algoritmos de codificación: Procesos sistemáticos para transformar datos en un formato adecuado para almacenamiento, transmisión o procesamiento eficiente y seguro.

- Tipos de algoritmos de codificación: Incluyen codificación de fuente, canal, línea y seguridad, cada uno con aplicaciones específicas, como compresión o protección de datos.

- Algoritmo de codificación de Huffman: Método de compresión sin pérdida que utiliza la frecuencia de aparición de símbolos para asignar códigos cortos a los más frecuentes.

- Algoritmo de codificación de Lempel-Ziv: Compresión sin pérdida que reemplaza cadenas repetidas con referencias cortas, usado en formatos como ZIP.

- Algoritmos de compresión de datos: Técnicas para reducir el tamaño de archivos, con tipos como la compresión con pérdida (JPEG) y sin pérdida (LZW).

- Aplicaciones de la codificación en ingeniería: Optimización de telecomunicaciones, almacenamiento, ciberseguridad y procesamiento de señales.

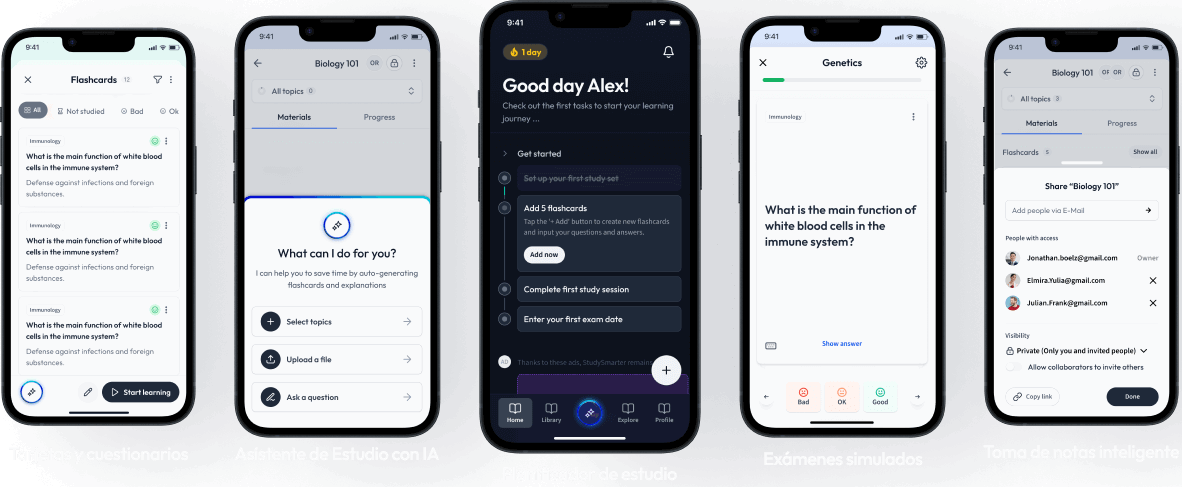

Aprende más rápido con las 24 tarjetas sobre algoritmos de codificación

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre algoritmos de codificación

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más