Saltar a un capítulo clave

Comprender la Teoría de la Información

La teoría de la información es un tema fascinante que afecta a varios aspectos de nuestra vida cotidiana, desde la forma en que nos comunicamos hasta cómo almacenamos y recuperamos datos. Te des cuenta o no, la teoría de la información desempeña un papel crucial en la tecnología moderna, ya que afecta a todo, desde tu smartphone hasta Internet.

¿Qué es la teoría de la información?

La teoría de la información es una rama de las matemáticas y la ingeniería eléctrica que se ocupa de la cuantificación, el almacenamiento y la comunicación de la información. Fue desarrollada por Claude Shannon a finales de la década de 1940 para encontrar límites fundamentales en las operaciones de procesamiento de señales, como la compresión de datos y la transmisión fiable de datos a través de un canal ruidoso.

Teoría de la Información: Estudio científico que se ocupa de la cuantificación, almacenamiento y comunicación de la información. Proporciona un marco matemático para comprender el flujo de información en los sistemas.

Principios clave de la Teoría de la Información

La teoría de la información se basa en un conjunto de principios clave que rigen el modo en que se procesa la información. Estos principios incluyen el concepto de entropía, que mide la incertidumbre de una variable aleatoria, y el teorema de la codificación de la fuente, que aborda los límites de la compresión de datos sin perder información.

Entropía: En la teoría de la información, la entropía es una medida de la imprevisibilidad o aleatoriedad de una fuente de datos. Cuanto mayor es la entropía, más difícil es predecir el siguiente fragmento de información.

Ejemplo de entropía:Considera el lanzamiento de una moneda. Si la moneda es justa, hay la misma probabilidad de que salga cara o cruz, lo que hace que el resultado sea impredecible. Esta situación tiene una entropía elevada. En cambio, si la moneda sale siempre cara, no hay incertidumbre y, por tanto, la entropía es baja.

Otro principio fundamental es la Capacidad del Canal, que incluye el teorema de Shannon. Define la velocidad máxima a la que puede transmitirse información de forma fiable a través de un canal de comunicación. Este principio sienta las bases de las tecnologías de transmisión de datos, como Internet y las telecomunicaciones móviles.

Capacidad del canal: La velocidad máxima a la que puede transmitirse información por un canal de comunicación con una probabilidad de error muy baja.

Cómo afecta la Teoría de la Información a nuestra vida cotidiana

Quizá te preguntes cómo afecta a tu vida cotidiana una teoría desarrollada a mediados del siglo XX. La verdad es que la teoría de la información está en todas partes. Está en los algoritmos de compresión que hacen posible la transmisión de vídeos en línea, en los códigos de corrección de errores que garantizan que tus mensajes de texto se reciban correctamente y en los sistemas criptográficos que mantienen seguras tus transacciones en línea.

Por ejemplo, el formato MP3 para archivos de música utiliza principios de la teoría de la información para comprimir los datos de audio, lo que permite almacenar las canciones con menos espacio sin afectar significativamente a la calidad del sonido. Del mismo modo, los códigos QR emplean códigos de corrección de errores para seguir siendo descifrables aunque estén parcialmente dañados.

El impacto de la teoría de la información se extiende más allá de la tecnología a diversos campos, incluida la biología, donde se ha utilizado para comprender la secuenciación del ADN y la transmisión de la información genética. Es un testimonio de la amplia aplicabilidad de estos principios.

La próxima vez que veas un vídeo en tu teléfono, recuerda que la teoría de la información contribuye a que ese vídeo llegue a tu pantalla de forma eficiente y sin errores.

Sumérgete en la Teoría de la Información de Shannon

La esencia de la teoría de la información se remonta al trabajo pionero de Claude Shannon a mediados del siglo XX. Comprender esta teoría permite comprender la transmisión, compresión y almacenamiento de datos, que son fundamentales para la tecnología moderna. Exploremos el genio que hay detrás de la teoría, su explicación y su impacto en nuestra vida cotidiana.

El genio de Claude Shannon

Claude Shannon, a menudo aclamado como el padre de la teoría de la información, introdujo conceptos que han influido profundamente en la era digital. Su innovador artículo "Una teoría matemática de la comunicación" sentó las bases para comprender cómo se transmite, almacena y procesa la información. El trabajo de Shannon es célebre por sus ingeniosas aportaciones a la codificación, la criptografía y las telecomunicaciones.La idea de Shannon del dígito binario, o bit, como unidad fundamental de información, revolucionó la forma de cuantificar la información. Esto condujo al desarrollo de los sistemas digitales de los que dependemos hoy en día, como los ordenadores, los teléfonos inteligentes e Internet.

Explicación de la Teoría de la Información de Shannon

La Teoría de la Información de Shannon es la columna vertebral de los sistemas de comunicación digital, ya que ofrece un marco matemático para cuantificar la información. En esencia, la teoría aborda dos problemas principales: la compresión de datos (codificación de la fuente) y la transmisión de datos (codificación del canal).Shannon introdujo el concepto de entropía, simbolizado como H, que mide la imprevisibilidad o aleatoriedad del contenido de la información. La fórmula de la entropía, para un caso simple en el que todos los sucesos tienen la misma probabilidad, viene dada por: \[H = -\suma p(x) \log p(x)\]. Esto cuantifica el contenido medio de información de un símbolo fuente.

Entropía: Medida de la imprevisibilidad o aleatoriedad de los datos, que indica la cantidad de información contenida en un mensaje. Una entropía alta significa que el mensaje contiene una gran cantidad de información, mientras que una entropía baja indica previsibilidad y menos información.

Ejemplo de Teoría de la Información en la compresión de datos:El formato de archivo ZIP utiliza algoritmos de compresión de datos que reducen el tamaño del archivo sin perder información. Esto se consigue identificando y eliminando la redundancia, haciendo que el tamaño de los archivos sea menor y más eficiente de almacenar y transmitir.

El principio de la capacidad del canal, introducido por Shannon, define la velocidad máxima a la que puede transmitirse información de forma fiable a través de un canal de comunicación. Dado un canal ruidoso con un ancho de banda B y una relación señal/ruido SNR, la capacidad C del canal se calcula como \[C = B \log_2(1 + SNR)\], donde C se mide en bits por segundo (bps). Este principio es fundamental para diseñar y evaluar los sistemas de comunicación.

Al comprender la entropía de un mensaje y la capacidad de un canal, la teoría de la información nos permite maximizar la eficacia de nuestros sistemas de comunicación. Nos indica los límites de lo que es posible en la compresión y transmisión de datos, guiando el diseño de todo, desde los protocolos de Internet hasta las redes móviles.

Aplicaciones reales de la Teoría de la Información de Shannon

Los principios de la teoría de la información encuentran aplicación en diversos aspectos de la vida cotidiana. Desde los aparatos que utilizamos hasta la forma en que nos comunicamos, la teoría de Shannon sustenta múltiples tecnologías.

- Las tecnologías de Internet y Wi-Fi se basan en algoritmos basados en los principios de Shannon para optimizar la transmisión de datos a través de las redes.

- La telefonía móvil, incluidas la 4G y la 5G, utiliza la corrección de errores y la codificación de canales para garantizar una comunicación clara e ininterrumpida.

- La compresión de archivos, tanto en formatos sin pérdidas como PNG, como en formatos con pérdidas como JPEG, utiliza la teoría de la información para reducir el tamaño de los archivos manteniendo la calidad de la imagen.

- Los métodos criptográficos utilizan principios de la obra de Shannon para proteger los datos y las comunicaciones contra los fisgones.

¿Te has dado cuenta alguna vez de que algunos sitios web se cargan increíblemente rápido, incluso con una conexión a Internet lenta? Esto se debe en parte a algoritmos eficientes, inspirados en la teoría de Shannon, que minimizan la cantidad de datos transmitidos sin sacrificar la calidad del contenido.

Explorando la Entropía en la Teoría de la Información

La entropía en la teoría de la información es un concepto fundamental que da forma a nuestra comprensión de los procesos de información, incluida la forma en que se comprimen, transmiten y almacenan los datos. Con raíces en la termodinámica, esta medida de incertidumbre o aleatoriedad tiene profundas implicaciones en los campos computacional y de la comunicación.

El concepto de entropía en la Teoría de la Información

La entropía, a menudo simbolizada como H, cuantifica la imprevisibilidad del contenido de un mensaje. Representa la velocidad media a la que una fuente estocástica de datos produce información. Cuanto mayor es la entropía, más información transmite cada símbolo por término medio, lo que conduce a una mayor incertidumbre en la predicción de símbolos individuales.El concepto establece paralelismos con la física, donde la entropía representa el desorden o la aleatoriedad. En la teoría de la información, encierra la idea de que los datos más aleatorios tienen mayor entropía y requieren más bits para una representación precisa.

Entropía: Medida utilizada en la teoría de la información para cuantificar la cantidad de incertidumbre o aleatoriedad de un conjunto de datos. Es fundamental para determinar el límite teórico de la compresión de datos.

Ejemplo de entropía:Si una fuente produce una larga secuencia de símbolos idénticos, la entropía de la secuencia es cero, ya que no hay incertidumbre. Por el contrario, si cada símbolo de una secuencia tiene la misma probabilidad y es independiente de los demás, esta fuente tiene la máxima entropía y los símbolos contienen la mayor cantidad de información.

Cálculo de la entropía en los sistemas de información

Para calcular la entropía en los sistemas de información, un enfoque habitual consiste en aplicar la fórmula de Shannon, donde la entropía H(X) de una variable aleatoria discreta X con valores posibles \(x_1, ..., x_n\) y función de masa de probabilidad P(X ) viene dada por: \[H(X) = -\suma_{i=1}^{n} P(x_i) \log_2 P(x_i)\]. Este cálculo requiere sumar el producto de la probabilidad de cada resultado con el log base 2 de esa probabilidad, lo que mide esencialmente el valor esperado del contenido informativo.Entender cómo calcular la entropía es crucial para optimizar los esquemas de codificación de datos, garantizando que la longitud media de los mensajes sea lo más parecida posible a la entropía de la fuente.

Considerando una fuente binaria que produce una serie de 0s y 1s, si ambos resultados son igualmente probables, la entropía H sería máxima a 1 bit por símbolo. Esto significa que cada símbolo de la fuente añade un bit de información. La intuición aquí es que cuando los resultados son impredecibles y aleatorios, se transmite más información. Así pues, comprender y calcular la entropía permite mejorar las estrategias de codificación y compresión de datos.

El papel de la entropía en la compresión y transmisión de datos

La entropía desempeña un papel fundamental en la compresión de datos, ya que determina el límite teórico hasta el que se puede comprimir la información sin perder ningún dato: la tasa de entropía. Influye tanto en las técnicas de compresión sin pérdidas como en las de compresión con pérdidas. Los métodos sin pérdidas, utilizados en archivos ZIP e imágenes PNG, tienen como objetivo no perder ninguna información, conservando la calidad original. Por el contrario, la compresión con pérdidas, aplicada en los formatos JPEG y MP3, sacrifica algunos datos a cambio de tamaños de archivo significativamente menores, basándose en el supuesto de que la información perdida es menos importante para el usuario final.Además, en la transmisión de datos, comprender la entropía es esencial para las técnicas de detección y corrección de errores. Una mayor entropía implica más aleatoriedad, lo que aumenta la posibilidad de errores durante la transmisión. Los esquemas de codificación eficientes, diseñados teniendo en cuenta la entropía, pueden reducir significativamente los errores de transmisión.

Los algoritmos de compresión, como la codificación Huffman, utilizan directamente el principio de entropía asignando códigos más cortos a los fragmentos de datos más frecuentes, reduciendo así la longitud media del mensaje codificado hasta acercarla a su valor de entropía.

Aprendizaje práctico con ejercicios de teoría de la información

Sumergirse en el mundo de la teoría de la información mediante ejercicios prácticos es un camino directo para comprender sus complejos conceptos. Desde ejercicios básicos hasta sofisticados algoritmos de inferencia y aprendizaje, dedicarse a estas tareas potencia una conexión más profunda con la teoría.Exploremos varios ejercicios que ayudarán a solidificar tu comprensión de la teoría de la información, centrándonos en la resolución de problemas, la aplicación de la inferencia y el aprendizaje de algoritmos, así como en la apreciación de sus aplicaciones en el mundo real.

Resolución de ejercicios básicos de teoría de la información

Empezar con ejercicios básicos es crucial para construir una base sólida en teoría de la información. Estos ejercicios suelen implicar cálculos de entropía, información mutua o capacidad de canal, que son fundamentales para comprender el tema. Algunos ejemplos de tareas son

- Calcular la entropía de una fuente dada.

- Determinar la información mutua entre dos variables aleatorias.

- Calcular la capacidad de un canal de comunicación.

Ejemplo de ejercicio:Calcula la entropía de una tirada de dados justa. Con cada uno de los seis resultados igual de probables, la entropía, H(X), en bits, se calcula como:\[H(X) = -\suma p(x_i) \log_2 p(x_i)\]\[= -6(\frac{1}{6}) \log_2 (\frac{1}{6})\]\[\aprox 2.58 \, bits\]Esto demuestra la cantidad media de información producida por cada tirada de dados.

Algoritmos de inferencia y aprendizaje de la Teoría de la Información

A medida que avances, comprender cómo aplicar la teoría de la información a los algoritmos de inferencia y aprendizaje automático se convierte en algo primordial. Estos ejercicios avanzados requieren utilizar la entropía y la información mutua para hacer inferencias sobre los datos, lo que conduce a algoritmos de aprendizaje más eficientes.Las aplicaciones de estos conceptos son vastas, y abarcan desde la mejora de los algoritmos de árboles de decisión en el aprendizaje automático hasta la mejora de los algoritmos de compresión para el almacenamiento y la transmisión de datos.

Ejercicio de ejemplo:Considera un escenario en el que necesitas inferir la relación entre dos variables de un conjunto de datos utilizando la información mutua. Calculando la información mutua, evalúas la dependencia entre variables, lo que te ayuda a identificar las características más informativas para los modelos de aprendizaje automático.

Ejemplo de código:

import numpy as npfrom sklearn.metrics import mutual_info_score# Simula dos variables dependientesx = np.random.uniform(0, 1, 1000)y = x + np.random.normal(0, 0.1, 1000)# Calcula la información mutuami = mutual_info_score(None, None, contingency=np.histogram2d(x, y, 20)[0])print(f'Información mutua: {mi}') Mejorar la comprensión mediante aplicaciones prácticas

Por último, traducir el conocimiento teórico en aplicaciones prácticas es donde brilla el verdadero poder de la teoría de la información. Esto incluye desde el diseño de sistemas de comunicación más eficientes hasta el desarrollo de algoritmos para comprimir y cifrar datos. Involucrarse en aplicaciones del mundo real no sólo solidifica la comprensión, sino que también muestra la versatilidad e indispensabilidad de la teoría de la información para abordar los retos tecnológicos contemporáneos.

Una aplicación notable de la teoría de la información es el diseño de códigos de corrección de errores, esenciales para la transmisión fiable de datos. Al comprender la capacidad del canal, los ingenieros pueden idear códigos que maximicen el rendimiento de los datos y minimicen los errores, incluso en entornos ruidosos. Estas aplicaciones demuestran la importancia práctica de los conceptos de la teoría de la información más allá de los ejercicios académicos.A medida que avanza la tecnología, los principios de la teoría de la información siguen sustentando las innovaciones en la ciencia de los datos, la inteligencia artificial y otros campos, lo que demuestra su relevancia atemporal.

Al abordar los ejercicios de teoría de la información, recuerda que estos conceptos no son meras abstracciones matemáticas, sino los principios mismos que impulsan la eficiencia del mundo digital que nos rodea.

Teoría de la información - Puntos clave

- Teoría de la Información: Rama de las matemáticas y la ingeniería eléctrica centrada en la cuantificación, almacenamiento y comunicación de la información, desarrollada principalmente por Claude Shannon.

- Entropía: Medida de la imprevisibilidad o aleatoriedad de una fuente de datos, que indica la cantidad de información de un mensaje.

- Capacidad del canal: Teorema de Shannon, que define la velocidad máxima a la que puede transmitirse información de forma fiable a través de un canal de comunicación.

- Teoría de la Información de Shannon: Teoría que proporciona un marco matemático para cuantificar la información, abordando conceptos como la compresión de datos (codificación de la fuente) y la transmisión de datos (codificación del canal).

- Ejercicios prácticos de Teoría de la Información: Actividades que incluyen el cálculo de la entropía, la información mutua, la capacidad del canal y la aplicación de la teoría de la información a algoritmos de inferencia y aprendizaje para mejorar la comprensión.

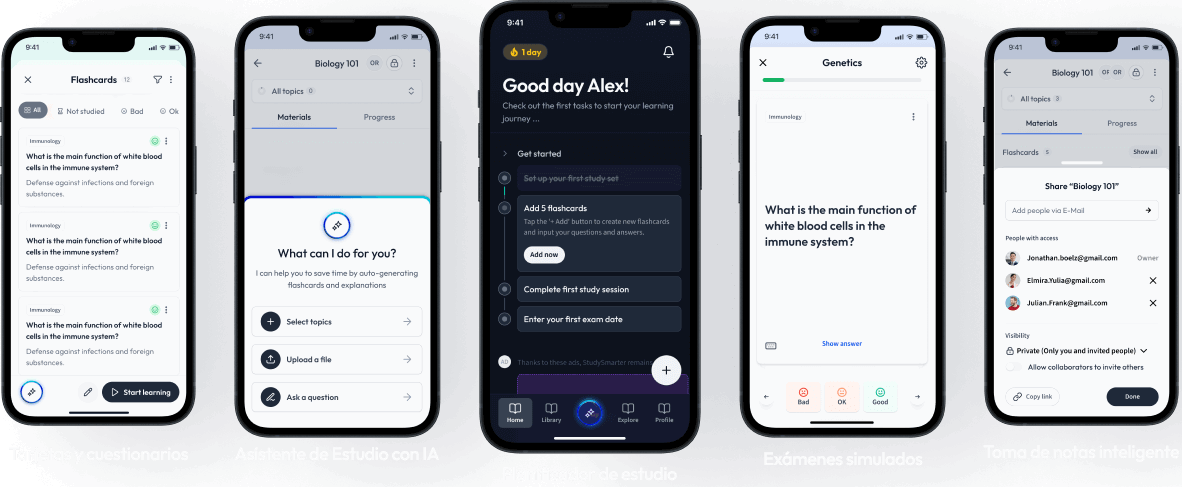

Aprende más rápido con las 12 tarjetas sobre Teoría de la información

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Teoría de la información

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más