Saltar a un capítulo clave

Introducción a la optimización matemática

La optimizaciónmatemática es una rama de las matemáticas aplicadas que consiste en encontrar la mejor solución entre un conjunto de alternativas disponibles, a menudo sujetas a ciertas restricciones. Abarca una amplia gama de técnicas y metodologías de resolución de problemas que son aplicables en diversos campos, como la economía, la ingeniería, la logística y las finanzas. El objetivo es maximizar o minimizar una función eligiendo sistemáticamente valores de entrada dentro de un conjunto permitido y calculando el valor de la función.

Comprender los fundamentos de la optimización matemática

En el núcleo de la optimización matemática se encuentra la función objetivo, una fórmula que define el criterio que hay que optimizar. Dependiendo del problema, esta función puede maximizarse, por ejemplo, maximizar los beneficios en un escenario empresarial, o minimizarse, como reducir los costes de transporte de mercancías. Las entradas de esta función se denominan variables y están sujetas a restricciones: limitaciones o requisitos que deben satisfacer dichas variables.

Función Objetivo: Función que define el criterio que hay que optimizar (maximizar o minimizar) en un problema matemático de optimización.

La importancia de la optimización matemática en las matemáticas aplicadas

La optimizaciónmatemática desempeña un papel fundamental en las matemáticas aplicadas, ya que proporciona un marco estructurado para resolver eficazmente problemas complejos del mundo real. Permite formular modelos que pueden analizarse y resolverse mediante diversas técnicas de optimización, ofreciendo así soluciones prácticas y óptimas. Mediante sus metodologías, la optimización matemática contribuye significativamente a los procesos de toma de decisiones en diversos campos, lo que la convierte en una herramienta indispensable tanto en la investigación como en las aplicaciones prácticas.

Los modelos de optimización pueden simplificar los complejos procesos de toma de decisiones al ofrecer perspectivas cuantificables.

El desarrollo y análisis de algoritmos para resolver problemas de optimización es un punto central de la investigación operativa, un campo multidisciplinar que combina las matemáticas, la informática y la estrategia empresarial para tomar decisiones informadas en escenarios complejos.

Cómo resuelve la optimización matemática los problemas del mundo real

La optimizaciónmatemática tiene una capacidad sin parangón para resolver diversos problemas del mundo real. Desde el diseño de rutas de transporte eficientes que ahorren tiempo y combustible, hasta la formulación de estrategias de inversión que maximicen los beneficios, las técnicas de optimización encuentran aplicaciones en diversos ámbitos. Además, en la fabricación, la optimización ayuda a planificar programas de producción que minimicen los costes y satisfagan la demanda, lo que demuestra su versatilidad e impacto.

Por ejemplo: En logística, el problema de encontrar la ruta más corta que puede tomar un camión de reparto para entregar mercancías a múltiples destinos se conoce como el Problema del Vendedor Viajero (TSP). La optimización matemática puede utilizarse para resolver el TSP de forma eficiente, garantizando la entrega a tiempo y la reducción de costes.

Los avances en potencia de cálculo y algoritmos han ampliado significativamente el alcance y la capacidad de la optimización matemática para abordar problemas que antes se consideraban intratables. La llegada del aprendizaje automático y la inteligencia artificial ha enriquecido aún más este campo al introducir modelos de optimización más dinámicos y adaptables.

Métodos de optimización matemática

La optimizaciónmatemática engloba una serie de métodos utilizados para encontrar la solución más eficiente u óptima a un problema, a menudo dentro de un conjunto de restricciones dadas. Estos métodos son esenciales en campos como la economía, la logística y la informática, por nombrar algunos, donde es crucial tomar decisiones óptimas. Comprender los métodos matemáticos de optimización más comunes proporciona una base para abordar problemas complejos en diversos ámbitos.

Visión general de los métodos matemáticos de optimización más comunes

A grandes rasgos, los métodos matemáticos de optimización pueden clasificarse en varios tipos, cada uno de los cuales se adapta a un tipo específico de problemas según la naturaleza de la función objetivo, las restricciones y las variables implicadas. A alto nivel, incluyen la programación lineal, la programación no lineal, la programación entera y la programación dinámica, entre otros.Aquí tienes una breve descripción de cada método:

- Programación lineal(PL): Se centra en problemas en los que la función objetivo y las restricciones son lineales. Se utiliza mucho en problemas de asignación de recursos, planificación y programación.

- ProgramaciónNo Lineal (PNL): Se ocupa de problemas que implican funciones objetivo o restricciones no lineales. Es aplicable en escenarios en los que la relación entre variables no es lineal.

- ProgramaciónEntera (PI): Similar a la PL, pero requiere que algunas o todas las variables de la solución sean números enteros. Suele utilizarse en situaciones en las que es necesario tomar decisiones discretas.

- Programación Dinámica (PD): Descompone un problema en subproblemas más sencillos y lo resuelve combinando las soluciones de los subproblemas. Adecuada para optimizar en el tiempo o en procesos de decisión secuenciales.

Técnicas de optimización lineal y no lineal

Comprender la diferencia entre las técnicas de optimización lineal y no lineal es fundamental para seleccionar el enfoque adecuado para resolver un problema. La optimización lineal implica problemas en los que la función objetivo y todas las restricciones son ecuaciones lineales. En cambio, la optimización no lineal es necesaria cuando se trata de problemas en los que la relación entre variables no es lineal, lo que significa que al menos una restricción o la función objetivo se desvía de la linealidad.Las técnicas lineales suelen ser más sencillas y directas de resolver, y ofrecen soluciones predecibles y estables. Los métodos no lineales, sin embargo, pueden enfrentarse a escenarios más complejos, pero a menudo requieren enfoques iterativos más sofisticados para encontrar una solución. Diversas herramientas de software y lenguajes de programación ofrecen bibliotecas diseñadas específicamente para abordar problemas lineales y no lineales.

Los problemas lineales suelen visualizarse como la búsqueda del punto óptimo en un polígono, mientras que los problemas no lineales pueden implicar encontrar el pico o el valle en una superficie curva.

El papel de los algoritmos en la optimización matemática

Los algoritmos desempeñan un papel crucial en la resolución de problemas de optimización matemática. Proporcionan procedimientos sistemáticos para realizar cálculos, procesar datos y automatizar el razonamiento, guiando esencialmente el camino para encontrar la solución óptima. Según la complejidad y el tipo de problema de optimización, se aplican distintos algoritmos.Por ejemplo, el algoritmo Simplex se utiliza habitualmente para problemas de programación lineal, mientras que el Descenso Gradiente o el Método de Newton pueden aplicarse a problemas no lineales. Los algoritmos evolutivos, como los Algoritmos Genéticos, se utilizan cuando el espacio de búsqueda es vasto y no está bien definido. La elección del algoritmo influye significativamente en la eficacia y la precisión de la solución encontrada.Además, el desarrollo de algoritmos para la optimización es un campo de investigación continuo, en el que se descubren regularmente nuevos enfoques y mejoras. Esta progresión no sólo aumenta la capacidad de resolver problemas más complejos, sino que también reduce los recursos informáticos necesarios, haciendo que la optimización sea más accesible en diversos campos.

El concepto de optimización convexa surge como un subconjunto notable dentro de la optimización matemática, sobre todo en el contexto de los problemas no lineales. Un problema se considera convexo si la región definida por sus restricciones forma un conjunto convexo, y la función objetivo es una función convexa. Esta propiedad es poderosa, ya que garantiza que cualquier mínimo local es también un mínimo global, lo que hace que la búsqueda de la solución óptima sea mucho más sencilla y fiable. La optimización convexa tiene profundas aplicaciones en el aprendizaje automático, el procesamiento de señales y la optimización de carteras financieras.

Técnicas matemáticas de optimización

Las técnicas de optimización matemática son esencialmente el conjunto de herramientas para resolver algunos de los problemas más complejos e intrigantes de diversas disciplinas científicas y de ingeniería. Ya se trate de encontrar la ruta más rápida para la entrega o de gestionar las inversiones para maximizar los beneficios, estas técnicas sustentan muchos de los procesos de toma de decisiones en el mundo actual.

Introducción al descenso gradiente y su importancia

El Descenso Gradiente es un algoritmo iterativo de optimización de primer orden para encontrar un mínimo local de una función diferenciable. Para entenderlo intuitivamente, considéralo como un método para descender una montaña por el camino de la pendiente más pronunciada para llegar más rápidamente a la base. Es especialmente crucial en el aprendizaje automático y el aprendizaje profundo para minimizar las funciones de coste y afinar los parámetros del modelo.

Descenso Gradiente: Algoritmo de optimización que se desplaza iterativamente hacia el mínimo de una función dando pasos proporcionales al negativo del gradiente (o gradiente aproximado) de la función en el punto actual.

Ejemplo: En el contexto de la regresión lineal, el Descenso Gradiente puede utilizarse para encontrar la línea de mejor ajuste minimizando la función de coste \[C = \frac{1}{m}\sum_{i=1}^{m}(y^{(i)} - (mx^{(i)} + b))^2\]Aquí, \(y^(i)}) y \(x^(i)}) representan los puntos de datos, \(m\) y \(b\) son la pendiente y la intersección y de la recta, respectivamente, y \(C\) es el coste que pretendemos minimizar.

Recocido simulado: Una técnica probabilística de optimización

El Recocido Simulado es una técnica probabilística para aproximarse al óptimo global de una función dada. Inspirado en el proceso de recocido en metalurgia, este método navega por el espacio de búsqueda aceptando probabilísticamente soluciones que son peores que la solución actual. Esto le permite escapar de los mínimos locales y ha demostrado su eficacia en problemas de optimización complejos en los que otros métodos pueden atascarse.

Recocido simulado: Técnica de optimización global que evita quedar atrapado en óptimos locales aceptando ocasionalmente estados peores durante el proceso de búsqueda, inspirada en el proceso físico de calentar y luego enfriar lentamente un material para reducir los defectos.

Ejemplo: Al intentar resolver el Problema del viajante de comercio, un algoritmo de recocido simulado podría aceptar inicialmente rutas más largas que la ruta más corta conocida en ese momento. Con el tiempo, reduce la probabilidad de aceptar rutas más largas, afinando la ruta óptima a medida que se enfría la "temperatura".

La utilidad de los multiplicadores de Lagrange en la optimización por restricciones

El método de los Multiplicadores de Lagrange es una estrategia para encontrar los máximos y mínimos locales de una función sujeta a restricciones de igualdad. Es una poderosa herramienta en la optimización con restricciones, que permite resolver problemas en los que la aplicación directa de gradientes se quedaría corta. Al introducir variables auxiliares conocidas como multiplicadores de Lagrange, transforma el problema con restricciones en un problema sin restricciones en un espacio de mayor dimensión.

Multiplicadores de Lagrange: Técnica utilizada en optimización matemática para encontrar los máximos y mínimos locales de una función sujeta a restricciones de igualdad, mediante la introducción de variables auxiliares (multiplicadores de Lagrange) para transformar un problema con restricciones en un problema sin restricciones en un espacio de mayor dimensión.

Ejemplo: Considera la maximización de la función \[f(x, y) = xy\]sujeta a la restricción \[g(x, y) = x + y - 10 = 0\].La función de Lagrange pasa a ser \[L(x, y, \lambda) = xy + \lambda (x + y - 10)\].Hallar las derivadas de \(L\) respecto a \(x\), \(y\) y \(\lambda\) y ponerlas a cero proporciona un sistema de ecuaciones para resolver \(x\), \(y\) y \(\lambda\), determinando el punto que maximiza \(f\) sujeto a \(g\).

Los multiplicadores de Lagrange no se limitan a funciones de dos variables y pueden aplicarse a funciones de muchas variables, lo que los convierte en una herramienta versátil en problemas de optimización multidimensional.

Ejemplos y aplicación de la optimización matemática

La optimizaciónmatemática es una estrategia fundamental utilizada en diversas industrias para resolver problemas complejos de forma eficaz. Consiste en seleccionar la mejor opción entre un conjunto de alternativas, dadas ciertas restricciones. Su aplicación abarca numerosos campos, como la logística, las finanzas y la producción, lo que la convierte en una herramienta fundamental en los procesos de toma de decisiones.

Optimización de la asignación de recursos: Un ejemplo práctico

Imagina una empresa de fabricación que quiere maximizar su producción dentro de unos límites presupuestarios. En este caso, la optimización matemática puede determinar la asignación óptima de recursos como materias primas, mano de obra y maquinaria para lograr la máxima eficiencia. Formulando el problema con variables que representen cantidades de recursos y una función objetivo para maximizar la producción, las restricciones podrían incluir límites presupuestarios y disponibilidad de materiales.

Ejemplo: Supongamos que una fábrica produce dos productos. El beneficio por unidad del producto A es de 10 £, y para el producto B, es de 15 £. La fábrica tiene un presupuesto de 500.000 £, donde la producción del producto A cuesta 2.000 £ por unidad, y la del producto B cuesta 3.000 £. El objetivo puede ser maximizar el beneficio, \(P = 10A + 15B\), sujeto a las restricciones \(2000A + 3000B \leq 500.000\) y a las restricciones de no negatividad \(A, B \geq 0\).

La optimización de los recursos implica no sólo maximizar la producción, sino también garantizar que los recursos se utilicen de la forma más eficiente y rentable.

Problemas de programación y soluciones de optimización matemática

Los problemas de programación implican asignar tareas dentro de unos plazos determinados, optimizando al mismo tiempo un objetivo, como minimizar el tiempo total de funcionamiento o los costes. La optimización matemática ofrece un marco sólido para estos problemas. Por ejemplo, en la programación de líneas aéreas, los algoritmos pueden programar vuelos teniendo en cuenta factores como la disponibilidad de la tripulación, el mantenimiento del avión y la demanda de pasajeros para minimizar los retrasos y maximizar la utilización de los recursos.

Ejemplo: Una compañía aérea pretende minimizar los tiempos de espera de los pasajeros y el tiempo de inactividad de la tripulación. Con los vuelos representados como variables y las restricciones que incluyen las limitaciones de los turnos de la tripulación y la disponibilidad de los aviones, un modelo de programación lineal puede optimizar la programación. La función objetivo podría formularse como \(Minimizar \sumaTiempoEspera +TiempoInactividadTripulación), sujeta a las restricciones mencionadas.

La programación eficiente en escenarios complejos suele implicar modelos iterativos y simulaciones para explorar numerosas permutaciones y combinaciones.

Casos prácticos: Éxitos reales en Matemáticas Aplicadas y Optimización

Los estudios de casos reales muestran el impacto de la optimización matemática en diversos sectores. Desde cadenas de suministro racionalizadas hasta métodos de producción que ahorran energía, estos éxitos ponen de relieve las ventajas prácticas de las técnicas de optimización en la toma de decisiones y la gestión de recursos.

Ejemplo: Una empresa de logística utilizó la optimización matemática para rediseñar sus rutas de reparto, lo que se tradujo en una reducción del 20% en el consumo de combustible. Al emplear un algoritmo para minimizar la distancia recorrida sin dejar de cumplir los plazos de entrega, la empresa redujo significativamente sus costes operativos y su impacto medioambiental.Otra historia de éxito procede del sector sanitario, donde un hospital empleó técnicas de optimización en la dotación de personal, reduciendo eficazmente los costes de las horas extraordinarias sin comprometer la atención a los pacientes.

El campo de la producción de energía ha experimentado avances sustanciales mediante la aplicación de la optimización matemática. Un caso notable es el de una empresa de energías renovables que optimizó la colocación de aerogeneradores para maximizar la captación de viento y minimizar el uso del suelo. Utilizando un complejo modelo que tiene en cuenta los patrones de viento, la topografía del terreno y las restricciones legales, la empresa pudo aumentar significativamente su producción de energía.Este ejemplo no sólo ilustra los beneficios financieros directos de la optimización, sino también su potencial para contribuir a los objetivos del desarrollo sostenible.

Teoría de la optimización en matemáticas

La teoría de la optimización en matemáticas es un campo amplio y crucial que se ha desarrollado para identificar la mejor solución entre un conjunto de soluciones factibles, guiándose por un conjunto específico de criterios. La teoría abarca diversos métodos, técnicas y principios destinados a resolver problemas complejos en numerosas disciplinas, desde la ingeniería a la economía y más allá.La optimización desempeña un papel integral en los procesos de toma de decisiones, en los que el objetivo final es maximizar la eficiencia, minimizar el coste o encontrar un equilibrio entre objetivos contrapuestos.

Principios básicos de la teoría de la optimización

Los fundamentos de la teoría de la optimización se basan en varios principios clave:

- Función Objetivo: Representación matemática del objetivo que se pretende alcanzar. Puede ser maximizar los beneficios, minimizar los costes o conseguir el mejor resultado posible dentro de unas limitaciones dadas.

- Variables: Los inputs o variables de decisión que pueden ajustarse para optimizar la función objetivo.

- Restricciones: Las condiciones que deben satisfacer las variables, que pueden incluir limitaciones de recursos, requisitos legales o restricciones tecnológicas.

- Conjunto de soluciones factibles: El conjunto de todas las soluciones posibles que satisfacen las restricciones. La solución óptima se busca dentro de este conjunto.

Problema de optimización: Problema matemático que consiste en encontrar la mejor solución entre todas las soluciones factibles, maximizando o minimizando una función objetivo, sujeta a un conjunto de restricciones.

En muchas aplicaciones del mundo real, la función objetivo y las restricciones no son necesariamente lineales, lo que lleva a clasificar los problemas en optimización lineal, optimización no lineal, programación entera y otros.

Evolución de la teoría de la optimización en matemáticas aplicadas

La evolución de la teoría de la optimización ha estado marcada por hitos significativos, pasando de problemas lineales sencillos a retos complejos y multidimensionales. La transición de modelos deterministas a otros que pueden manejar la incertidumbre y la variabilidad ha ampliado la aplicabilidad de la optimización.Entre los avances clave se incluyen:

- La formulación del método simplex por George Dantzig en la década de 1940, que revolucionó la programación lineal.

- La introducción de las condiciones de Karush-Kuhn-Tucker (KKT) para los problemas de programación no lineal.

- La incorporación de elementos estocásticos en los modelos, permitiendo la optimización en entornos inciertos.

Cómo influye la teoría de la optimización en los métodos computacionales modernos

El impacto de la teoría de la optimización en los métodos computacionales modernos es profundo, ya que facilita el diseño y la aplicación de algoritmos que pueden resolver problemas del mundo real a escalas sin precedentes. Los avances en potencia de cálculo y eficiencia algorítmica han permitido la optimización de sistemas cada vez más complejos, que van desde redes logísticas a redes energéticas, e incluso el entrenamiento de modelos de aprendizaje automático.Entre las principales influencias se incluyen:

- El desarrollo de algoritmos eficientes para problemas de optimización a gran escala.

- La aplicación de la optimización en el aprendizaje automático para el entrenamiento y la selección de modelos.

- El uso de la informática paralela y los recursos en la nube para resolver problemas de optimización más rápido y a mayor escala que nunca.

Un área notable en la que la teoría de la optimización ha desempeñado un papel fundamental es el campo de la investigación operativa. Aquí, los complejos procesos de toma de decisiones, como la programación, el trazado de rutas y la asignación de recursos, se formulan como problemas de optimización. La investigación operativa utiliza un sinfín de técnicas de optimización para llegar a las mejores decisiones posibles con unas limitaciones dadas, mejorando significativamente la eficiencia y la eficacia operativas. Este enfoque interdisciplinar, que combina matemáticas, informática y principios económicos, subraya la versatilidad y aplicabilidad de la teoría de la optimización para resolver problemas prácticos.

Optimización matemática - Puntos clave

- Optimización matemática: Rama de las matemáticas aplicadas centrada en la selección de la mejor solución entre un conjunto de alternativas, sujeta a restricciones, con el fin de maximizar o minimizar una función objetivo.

- Función objetivo: Fórmula matemática que define el criterio a optimizar, como maximizar los beneficios o minimizar los costes, con entradas conocidas como variables sujetas a ciertas restricciones.

- Técnicas de optimización: Incluyen la programación lineal, la programación no lineal, la programación entera y la programación dinámica, cada una adecuada para tipos específicos de problemas basados en la naturaleza de la función objetivo y las restricciones.

- Ejemplos de optimización: Las aplicaciones del mundo real en diversos campos como la economía, la logística, la fabricación, las finanzas y la ingeniería demuestran la capacidad de resolución de problemas de los métodos matemáticos de optimización.

- Teoría de la optimización en matemáticas: Abarca métodos, técnicas y principios destinados a resolver problemas complejos, que implican una función objetivo, variables, restricciones y un conjunto de soluciones factibles.

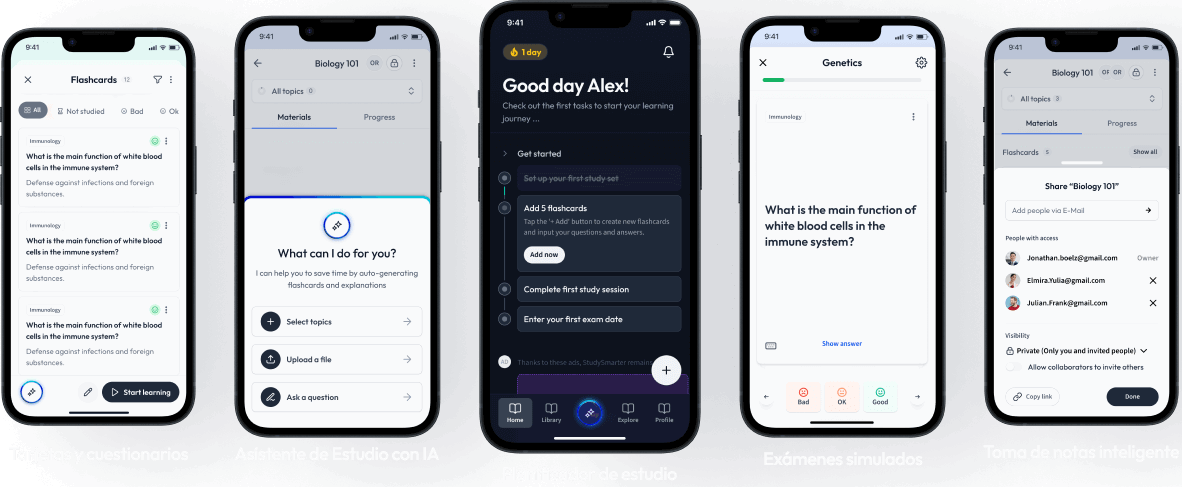

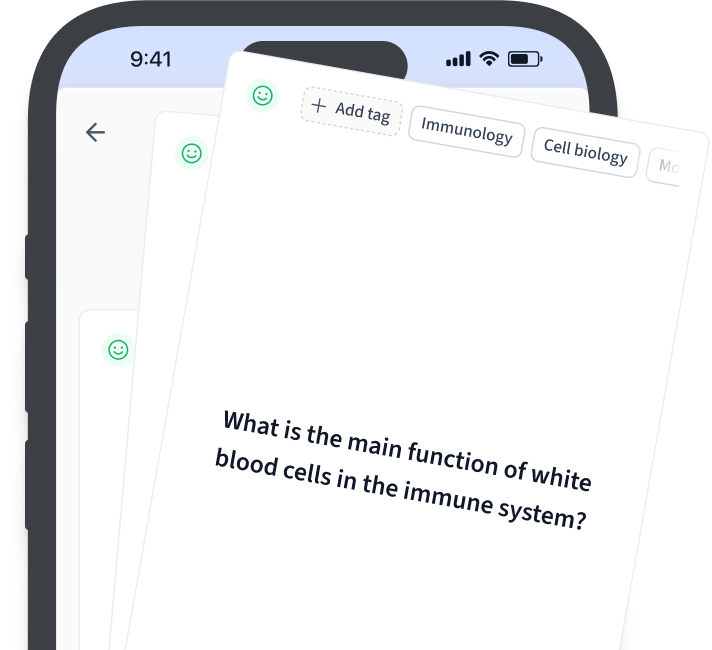

Aprende más rápido con las 15 tarjetas sobre Optimización matemática

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Optimización matemática

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más