Saltar a un capítulo clave

¿Qué es el control óptimo?

El controlóptimo es un marco matemático para determinar el mejor curso de acción para un sistema dado. El objetivo principal es encontrar una política de control que minimice o maximice un determinado criterio de rendimiento, normalmente a lo largo del tiempo. Esto implica resolver complejas ecuaciones diferenciales y utilizar el cálculo de variaciones, entre otras técnicas matemáticas. La teoría del control óptimo es ampliamente aplicable en diversos campos, como la ingeniería, la economía y la inteligencia artificial.

Comprender los fundamentos de la Teoría del Control Óptimo

La teoría del control óptimo gira en torno a la búsqueda de una función de control que optimice una función objetivo sujeta a ciertas restricciones. Esto se formula generalmente mediante una función de coste que hay que minimizar (o una función de utilidad que hay que maximizar) sobre las funciones de control.

Función de control: Función matemática que describe las acciones o entradas que pueden ajustarse en un sistema para influir en su comportamiento.

Ejemplo: En un vehículo autónomo, la función de control podría incluir variables como la velocidad y el ángulo de giro, que se ajustan para garantizar un desplazamiento seguro y eficaz.

El proceso implica plantear un problema de optimización en el que la dinámica del sistema se define mediante ecuaciones diferenciales, y el objetivo es encontrar las leyes de control que consigan el resultado deseado. La dificultad de los problemas de control óptimo se deriva de la necesidad de predecir los estados futuros de un sistema en condiciones variables.

En el control óptimo se suele utilizar el cálculo de variaciones para encontrar la trayectoria de control que minimiza o maximiza la función objetivo.

Un concepto central en la teoría del control óptimo es la función hamiltoniana, que integra la función de coste con la dinámica del sistema. Resolver el Hamiltoniano permite conocer las estrategias de control que pueden optimizar el rendimiento del sistema.

Ejemplo: Para el funcionamiento energéticamente eficiente de un motor eléctrico, el problema de control óptimo podría tener como objetivo minimizar el consumo de energía sujeto a las restricciones de funcionamiento del motor. El Hamiltoniano incluiría tanto la función de coste energético como las ecuaciones dinámicas del motor.

ElPrincipio del Máximo de Pontryagin es una piedra angular de la teoría del control óptimo. Proporciona un conjunto de condiciones necesarias para la optimalidad en un problema de control. Este principio ayuda a resolver problemas de control en los que las funciones de control están acotadas y el comportamiento del sistema se describe mediante ecuaciones diferenciales ordinarias.

La importancia del control óptimo en las matemáticas aplicadas

El control óptimo desempeña un papel fundamental en las matemáticas aplicadas, ya que proporciona herramientas y técnicas para resolver problemas del mundo real en diversas disciplinas. Su importancia radica en la capacidad de abordar sistemáticamente los procesos de toma de decisiones y de control.

Sus aplicaciones abarcan desde la gestión de carteras de inversión en finanzas, hasta el diseño de sistemas de control en ingeniería aeroespacial y la optimización de protocolos de tratamiento en sanidad. El control óptimo proporciona un marco riguroso para tomar decisiones eficientes bajo restricciones e incertidumbres.

En ingeniería, por ejemplo, las técnicas de control óptimo se utilizan para diseñar sistemas que funcionen eficazmente en una amplia gama de condiciones operativas. Esto incluye desde la robótica y los procesos de fabricación automatizados hasta los sistemas de control climático de los edificios.

Por ejemplo: En robótica, el control óptimo puede utilizarse para programar los movimientos de un robot y garantizar que realice las tareas de la forma más eficiente, teniendo en cuenta limitaciones como el consumo de energía y el tiempo.

La interacción de la teoría matemática y los métodos computacionales en el control óptimo también abre nuevas posibilidades para la investigación en sistemas y dinámicas complejas. Al aprovechar los algoritmos numéricos y las técnicas de simulación, la teoría del control óptimo ayuda a idear soluciones eficaces y factibles desde el punto de vista computacional.

El aprendizaje automático y el control óptimo se entrecruzan cada vez más, y se diseñan algoritmos para optimizar automáticamente las estrategias de control en entornos complejos.

Exploración de distintos enfoques del control óptimo

El control óptimo implica la búsqueda de la mejor estrategia posible para dirigir un sistema o un proceso hacia un estado deseado, durante un periodo determinado. Este viaje abarca diversas metodologías, cada una adecuada a distintos tipos de problemas y dominios. Entre ellas, la programación dinámica, el control óptimo estocástico y el regulador lineal cuadrático destacan por sus distintos enfoques y amplias aplicaciones.

Programación dinámica y control óptimo: Una relación esencial

La programación dinámica es un método utilizado en el control óptimo que descompone un problema complejo en subproblemas más sencillos. Es especialmente eficaz para problemas en los que las decisiones tomadas en un momento dado afectan a las posibilidades futuras, por lo que es necesario considerar toda la secuencia de toma de decisiones.

Programación dinámica: Método para resolver problemas complejos descomponiéndolos en subproblemas más sencillos. Se utiliza en el control óptimo para encontrar una política que minimice o maximice el coste o la recompensa acumulados.

Ejemplo: Considera un robot de almacén automatizado encargado de mover cajas desde varias ubicaciones hasta una zona de carga. Mediante la programación dinámica, se calcula una ruta óptima que minimice el tiempo total o la energía consumida, teniendo en cuenta todas las rutas posibles, el peso de las cajas y otros criterios.

La relación entre la programación dinámica y el control óptimo se manifiesta en la formulación de la ecuación de Bellman, que expresa el principio de optimalidad. Esta ecuación sirve de base para resolver problemas de control descomponiéndolos recursivamente en subfases más manejables.

El principio de optimalidad afirma que una política óptima tiene la propiedad de que, sean cuales sean el estado inicial y la decisión inicial, las decisiones restantes deben constituir una política óptima con respecto al estado resultante de la primera decisión.

Control Óptimo Estocástico: Gestión de la incertidumbre

La incertidumbre es un aspecto prevalente de muchos sistemas y procesos. El control óptimo estocástico lo aborda incorporando elementos probabilísticos al modelo de control, lo que permite gestionar sucesos o perturbaciones impredecibles.

Control Óptimo Estocástico: Rama de la teoría del control óptimo que se ocupa de los sistemas influidos por procesos aleatorios. Trata de encontrar estrategias de control que tengan en cuenta la incertidumbre en la dinámica del sistema.

Ejemplo: En el sector financiero, el control óptimo estocástico es vital para gestionar las carteras de inversión. Dada la naturaleza impredecible de los rendimientos del mercado, se desarrollan modelos para ajustar dinámicamente las estrategias de inversión, maximizando los rendimientos esperados y minimizando el riesgo.

Este enfoque utiliza ecuaciones diferenciales estocásticas para modelizar la dinámica del sistema, cuyas soluciones ofrecen una visión de las políticas óptimas en condiciones de incertidumbre. A menudo se emplean métodos computacionales, como las simulaciones de Montecarlo, para aproximar soluciones a estos complejos problemas.

Incorporar la aleatoriedad a los modelos de control ayuda a prepararse para una amplia gama de resultados, haciendo que los sistemas sean más robustos y adaptables al cambio.

El regulador cuadrático lineal en el control óptimo

El regulador cuadrático lineal (RCL) es uno de los métodos más fundamentales y utilizados en el control óptimo. Diseñado para sistemas lineales sujetos a costes cuadráticos, el LQR proporciona un enfoque sencillo pero potente para el diseño de leyes de control.

Regulador Cuadrático Lineal (LQR): Una estrategia de control óptimo diseñada específicamente para sistemas lineales en los que el índice de rendimiento es cuadrático en las variables de estado y de control. Su objetivo es minimizar la función de coste, normalmente representada como una suma de los cuadrados de determinados parámetros del sistema y variables de control.

Ejemplo: Para un sistema de dirección de un coche autónomo, el uso del LQR podría implicar la minimización de una función de coste que incluya términos para la desviación de la trayectoria deseada, el esfuerzo de dirección y el índice de cambio de dirección, lo que llevaría a un seguimiento de la trayectoria suave y eficiente.

La principal ventaja del enfoque LQR reside en su capacidad para ofrecer soluciones explícitas para las ganancias de retroalimentación, lo que facilita su aplicación en comparación con estrategias de control más complejas. Equilibra eficazmente la compensación entre el rendimiento del sistema y la energía o el esfuerzo que requieren las entradas de control.

La ecuación de Riccati, central en el problema LQR, proporciona la base matemática para determinar la ley de control óptima. Resolviendo esta ecuación, se pueden calcular las ganancias de realimentación necesarias que conducen de forma óptima al sistema hacia el estado deseado, minimizando el coste acumulado a lo largo del tiempo.

El énfasis de la LQR en la linealidad y los costes cuadráticos puede limitar su aplicabilidad a sistemas con dinámicas no lineales o consideraciones de costes diferentes, lo que pone de relieve la importancia de seleccionar la estrategia de control adecuada en función del contexto específico del problema.

Resolver un problema de control óptimo

Resolver un problema de control óptimo implica identificar la mejor política para controlar un sistema dentro de unas restricciones dadas. Este proceso requiere un enfoque estructurado, que combine teorías matemáticas, algoritmos y una comprensión de la dinámica del sistema. Los problemas de control óptimo aparecen en diversos campos, ofreciendo soluciones que minimizan los costes, maximizan la eficiencia o alcanzan objetivos de rendimiento específicos.

Pasos para formular un problema de control óptimo

La formulación de un problema de control óptimo es crucial para encontrar su solución. He aquí los pasos habituales de este proceso:

- Definir la dinámica del sistema mediante ecuaciones diferenciales.

- Especificar el índice de rendimiento o la función de coste que hay que optimizar.

- Identificar las restricciones sobre las variables de control y el estado del sistema.

- Seleccionar una estrategia de control adecuada en función de las características del sistema y de la naturaleza del problema.

Dinámica del sistema: La descripción matemática de cómo cambia el estado de un sistema a lo largo del tiempo, a menudo expresada mediante ecuaciones diferenciales.

Ejemplo: Considera un depósito sencillo con una válvula de entrada y salida, el control del nivel de agua puede modelizarse con ecuaciones diferenciales que representen los caudales. Optimizar el nivel de agua para diversos objetivos, como minimizar el desbordamiento o maximizar la conservación del agua, puede conseguirse mediante un control óptimo.

El índice de rendimiento en un problema de control óptimo, a menudo denominado función de coste, se formula para expresar el objetivo de la tarea de control. Puede incluir términos para los estados del sistema que deben minimizarse o maximizarse y también puede tener en cuenta el esfuerzo de control.Las restricciones en los problemas de control óptimo garantizan que la solución sea factible teniendo en cuenta las limitaciones físicas, medioambientales o de diseño.

La elección de la función de costes influye significativamente en la solución de un problema de control óptimo, ya que refleja las prioridades operativas del sistema.

Explicación de la teoría del control óptimo: De la teoría a la práctica

La teoría del control óptimo proporciona un marco sólido para analizar y resolver problemas de control. Pasar de la teoría a la práctica implica traducir los modelos matemáticos en políticas de control procesables. Este proceso se apoya en algoritmos computacionales y en la experimentación en el mundo real. A continuación se ofrece una visión general de cómo se aplica en la práctica la teoría del control óptimo:

- Utilización de métodos numéricos para resolver el problema de control, incluidas la programación dinámica y las técnicas de control estocástico.

- Simulación del sistema para probar y perfeccionar las estrategias de control.

- Aplicación de políticas de control en sistemas del mundo real, y posterior supervisión y ajuste basados en datos de rendimiento.

Una de las herramientas matemáticas clave en la teoría del control óptimo es la función hamiltoniana. Integra la función de coste con las restricciones impuestas por la dinámica del sistema. Para un sistema descrito por el vector de estado \(x(t)\) y el vector de control \(u(t)\), el Hamiltoniano \(H\) puede representarse como \[H(x(t), u(t), \lambda(t)) = L(x(t), u(t)) + \lambda(t)^T f(x(t), u(t))\]donde \(L(x(t), u(t))\) es la función de coste instantáneo, \(f(x(t), u(t))\) describe la dinámica del sistema, y \(\lambda(t)\) son los multiplicadores de Lagrange asociados a las restricciones. La resolución de \(u(t)\) que minimiza o maximiza \(H\) guía el desarrollo de políticas de control óptimas.

Ejemplo: En el contexto de la optimización de la trayectoria de una nave espacial, el problema de control óptimo podría centrarse en minimizar el consumo de combustible. En este caso, el estado del sistema podría incluir la posición y la velocidad de la nave espacial, mientras que las variables de control incluirían las direcciones y magnitudes de los empujes aplicados. La aplicación práctica implicaría crear un modelo de simulación de la nave espacial, aplicar métodos numéricos para resolver el problema de control óptimo y probar la trayectoria resultante en un entorno simulado antes de la aplicación real.

Las aplicaciones prácticas del control óptimo suelen requerir un perfeccionamiento iterativo, ya que las complejidades e incertidumbres del mundo real pueden exigir ajustes del modelo teórico.

Aplicaciones del control óptimo en el mundo real

La teoríadel control óptimo encuentra su aplicación en numerosos escenarios del mundo real, en los que el objetivo es conseguir el mejor resultado posible con unas restricciones dadas. Esta teoría no es sólo un concepto matemático abstracto; es una herramienta práctica que mejora la eficiencia y la eficacia en diversos campos. Entre sus amplias aplicaciones, la robótica y la ingeniería financiera destacan por su dependencia de los principios del control óptimo y los beneficios que obtienen de ellos. Comprender las aplicaciones del control óptimo en el mundo real ayuda a apreciar su importancia y el amplio impacto que tiene en distintos ámbitos.

Control óptimo en robótica: Mejora de la eficacia

En robótica, el control óptimo es fundamental para diseñar sistemas eficientes y eficaces. Los robots, con su diversa gama de aplicaciones, desde la fabricación industrial a la conducción autónoma y las cirugías médicas, requieren mecanismos de control precisos para un rendimiento óptimo. Mediante la aplicación de la teoría del control óptimo, los sistemas robóticos pueden conseguir una mayor eficacia, precisión y autonomía. La aplicación del control óptimo en robótica abarca diversas tareas, como la planificación de trayectorias, el control del movimiento y la minimización del consumo de energía. Al modelar estas tareas como problemas de control óptimo, los especialistas en robótica pueden derivar estrategias de control que optimicen los objetivos deseados, como la trayectoria más corta o el consumo mínimo de energía, sujetos a las restricciones dinámicas del robot y a las interacciones con el entorno.

Ejemplo: Consideremos un brazo robótico utilizado en una cadena de montaje de una fábrica. El objetivo es minimizar el tiempo que tarda en mover las piezas de una estación a otra evitando los obstáculos. Formulándolo como un problema de control óptimo, en el que la posición y la velocidad del robot son variables controladas, puede obtenerse una solución que dicte la estrategia de movimiento óptima. Esto garantiza que el brazo robótico funcione con eficacia, reduciendo los tiempos de ciclo y mejorando la productividad general de la línea de producción.

La tarea de planificación de trayectorias en robótica es un ejemplo clásico en el que se utiliza el control óptimo para determinar la ruta más eficiente, teniendo en cuenta los obstáculos dinámicos y las capacidades físicas del robot.

El papel del control óptimo en la ingeniería financiera

La ingeniería financiera utiliza la teoría del control óptimo para diseñar estrategias que maximicen los beneficios y minimicen los riesgos en las carteras de inversión. En el mundo estocástico y a menudo impredecible de las finanzas, la consecución de los resultados financieros deseados requiere sofisticados modelos de toma de decisiones. El control óptimo ofrece un marco para tomar tales decisiones, empleando técnicas de control estocástico para tener en cuenta la aleatoriedad inherente a los mercados financieros. Aplicando el control óptimo a la ingeniería financiera, los inversores y gestores de carteras pueden ajustar dinámicamente sus estrategias de inversión en función de las condiciones cambiantes del mercado. Esto aumenta la capacidad de responder eficazmente a las volatilidades del mercado, optimizando el rendimiento de la cartera a lo largo del tiempo.

Control Estocástico: Rama de la teoría del control óptimo que se ocupa de los sistemas influidos por procesos aleatorios, especialmente frecuentes en los mercados financieros, donde la incertidumbre es un factor constante.

Ejemplo: Al gestionar una cuenta de ahorro para la jubilación, un inversor pretende maximizar los rendimientos esperados minimizando el riesgo de pérdidas significativas. Modelizando el problema de la inversión como un problema de control óptimo estocástico, pueden derivar una política de inversión dinámica. Esta política ajusta la asignación de activos de la cartera en tiempo real, en función de la evolución de las condiciones del mercado y de la tolerancia al riesgo del individuo, garantizando que los objetivos de jubilación se cumplan de forma eficiente.

La aplicación de la programación dinámica estocástica a la ingeniería financiera ilustra la profundidad del impacto del control óptimo. Este enfoque permite modelizar las decisiones de inversión como una serie de elecciones interrelacionadas realizadas en condiciones de incertidumbre. Por ejemplo, un gestor de cartera que decide si comprar, mantener o vender un activo puede considerarse que resuelve un problema de control óptimo dinámico, cuyo objetivo es maximizar el valor a largo plazo de la cartera. Estos sofisticados modelos tienen en cuenta diversos factores, como las tendencias del mercado, los tipos de interés y los indicadores económicos, para guiar los procesos de toma de decisiones en tiempo real.

La incertidumbre inherente al mercado financiero hace del control óptimo estocástico una herramienta indispensable para desarrollar estrategias de inversión sólidas que puedan resistir las volatilidades del mercado.

Control óptimo - Puntos clave

- Control óptimo: Marco matemático destinado a encontrar una política de control que minimice o maximice un determinado criterio de rendimiento, utilizando ecuaciones diferenciales complejas y cálculo de variaciones.

- Función de control: Describe las acciones o entradas ajustables en un sistema, como la velocidad y el ángulo de giro en un vehículo autónomo, para influir en su comportamiento.

- Función Hamiltoniana: Central en la teoría del control óptimo, combina la función de coste con la dinámica del sistema, ofreciendo una visión de las estrategias de control que pueden optimizar el rendimiento del sistema.

- Programación dinámica y control óptimo: Método que consiste en descomponer problemas complejos en subproblemas, utilizando la ecuación de Bellman para resolver problemas de control basados en el principio de optimalidad.

- Control Óptimo Estocástico: Se ocupa de los sistemas afectados por la aleatoriedad, utilizando ecuaciones diferenciales estocásticas para modelar la dinámica del sistema y fundamentar las decisiones en condiciones de incertidumbre.

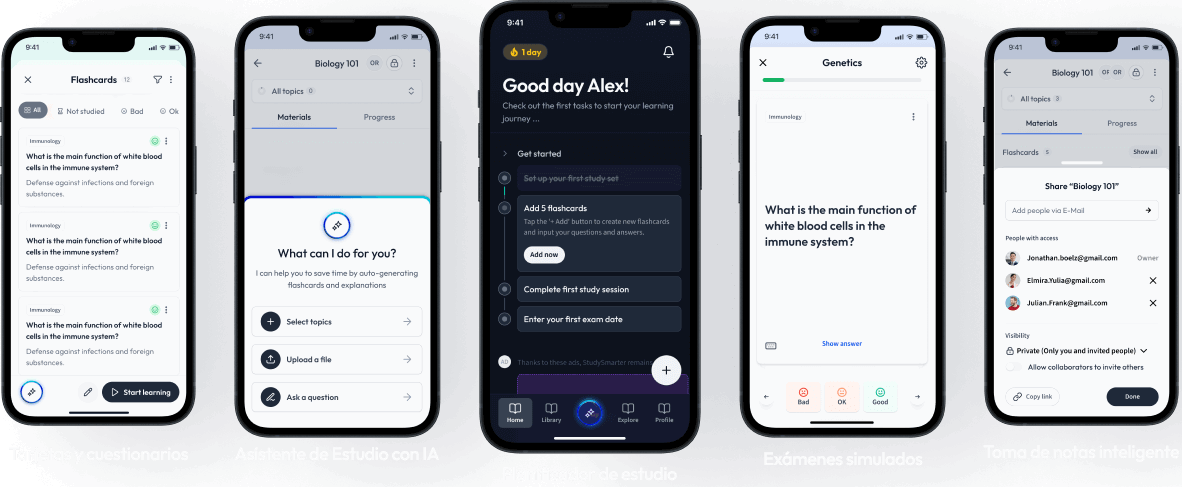

Aprende más rápido con las 24 tarjetas sobre Control óptimo

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Control óptimo

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más