Saltar a un capítulo clave

Comprensión de los Procesos de Decisión de Markov

Los Procesos de Decisión de Markov (MDP) son un marco matemático utilizado para modelizar la toma de decisiones en situaciones en las que los resultados son en parte inciertos y en parte están bajo el control de quien toma la decisión. Este concepto se aplica ampliamente en diversos campos, como la robótica, la economía y la inteligencia artificial. Comprender los MDP puede ser una tarea difícil pero gratificante, ya que proporciona una visión de los complejos procesos de toma de decisiones.

Definición del Proceso de Decisión de Markov

Un Proceso de Decisión de Markov se define como un marco matemático para modelizar la toma de decisiones secuenciales en situaciones en las que los resultados son en parte aleatorios y en parte están bajo el control de un decisor. Comprende estados, acciones, probabilidades de transición y recompensas, con el objetivo de determinar la mejor acción a realizar en cada estado para maximizar la recompensa acumulada a lo largo del tiempo.

Componentes clave de los Procesos de Decisión de Markov

La comprensión de los Procesos de Decisión de Markov se basa en la comprensión de sus componentes clave, que incluyen estados, acciones, probabilidades de transición y recompensas. Estos elementos trabajan juntos para formar la base de cualquier modelo MDP, permitiendo una planificación elaborada bajo incertidumbre.

- Estados: Las distintas situaciones o configuraciones en las que puede existir el sistema considerado.

- Acciones: Las decisiones o intervenciones que puede tomar el decisor para pasar de un estado a otro.

- Probabilidades de transición: Representan la probabilidad de pasar de un estado a otro, dada una acción.

- Recompensas: Valores numéricos asignados a las transiciones de un estado a otro, que indican la ganancia inmediata de esa transición.

Considera un ejemplo sencillo de un robot que navega por una pequeña cuadrícula. Las celdas de la cuadrícula representan diferentes estados, y el robot puede elegir entre varios movimientos o acciones (arriba, abajo, izquierda, derecha) en cada celda, con ciertas probabilidades de moverse con éxito en la dirección elegida(probabilidades de transición). Alcanzar algunas celdas puede suponer una recompensa positiva (por ejemplo, encontrar una estación de carga), mientras que otras pueden conllevar una penalización (por ejemplo, chocar con un obstáculo).

Comprender las probabilidades de transición y las recompensas es crucial para definir el comportamiento del decisor en un modelo MDP.

En escenarios más complejos, como los que implican sistemas multiagente o entornos parcialmente observables, se pueden añadir capas adicionales al marco MDP, como acciones que afectan a otras entidades o políticas que dependen de una visión limitada del estado. Sin embargo, en su núcleo, cada decisión en un MDP puede remontarse a los cuatro componentes clave: estados, acciones, probabilidades de transición y recompensas, lo que ilustra la amplia aplicabilidad de este modelo.

Profundizando en el Aprendizaje por Refuerzo de los Procesos de Decisión de Markov

Los Procesos de Decisión de Markov (PDM) proporcionan un marco fundacional para el aprendizaje por refuerzo, un tipo de aprendizaje automático en el que un agente aprende a tomar decisiones realizando acciones y recibiendo información del entorno. Estos conceptos están profundamente entrelazados, y los MDP son la base matemática de muchos algoritmos de aprendizaje por refuerzo.

Cómo impulsan el aprendizaje por refuerzo los procesos de decisión de Markov

En el aprendizaje por refuerzo, un agente interactúa con su entorno en una secuencia de pasos. En cada paso, el agente elige una acción, y el entorno responde presentando un nuevo estado y una recompensa. El objetivo del agente es aprender una política -una correspondencia entre estados y acciones- que maximice la recompensa acumulada a lo largo del tiempo. Los Procesos de Decisión de Markov constituyen la base de esta interacción al proporcionar una forma sistemática de modelar el entorno y el proceso de toma de decisiones.

La política en el aprendizaje por refuerzo se define como \(\pi(a|s)\), que representa la probabilidad de realizar la acción \(a\) en el estado \(s\). El objetivo es encontrar la política óptima \(\pi^*\) que maximice la suma esperada de recompensas, a menudo expresada como \(\sum_{t=0}^{\infty} \gamma^t R_{t+1}\), donde \(\gamma\) es un factor de descuento (\(< 1\)) y \(R_t\) es la recompensa en el momento \(t\). Esta formulación pone de relieve la toma de decisiones en condiciones de incertidumbre y las compensaciones entre recompensas inmediatas y futuras, aspectos centrales de los MDP.

Imagina un robot que navega por un laberinto en el que cada posición en el laberinto corresponde a un estado, y las posibles direcciones en las que puede moverse (por ejemplo, izquierda, derecha, arriba, abajo) representan las acciones. El robot recibe recompensas por llegar al final del laberinto y penalizaciones por chocar contra las paredes. Al explorar el laberinto y recibir retroalimentación (recompensas o penalizaciones), el robot aprende gradualmente la mejor ruta, aprendiendo efectivamente la política óptima para el Proceso de Decisión de Markov dado.

Aplicaciones reales del aprendizaje por refuerzo del proceso de decisión de Markov

El aprendizaje por refuerzo basado en MDP se ha aplicado con éxito en una amplia gama de escenarios del mundo real. Desde vehículos autónomos que circulan entre el tráfico hasta estrategias algorítmicas de negociación en el mercado de valores, los principios de los MDP guían el desarrollo de sistemas capaces de tomar decisiones complejas en entornos inciertos.

- Cibersalud: Las estrategias de tratamiento personalizadas para los pacientes pueden optimizarse utilizando modelos MDP, adaptando las intervenciones en función del estado evolutivo de la salud del paciente.

- Gestión de recursos: En la computación en nube, los MDP ayudan a asignar dinámicamente los recursos para satisfacer la demanda minimizando los costes.

- Robótica: Desde los robots de limpieza doméstica hasta la automatización industrial, las MDP sustentan los algoritmos de toma de decisiones que permiten a los robots realizar tareas de forma autónoma.

- Juegos: Los agentes de inteligencia artificial de los videojuegos utilizan el aprendizaje por refuerzo para mejorar su estrategia frente a los jugadores humanos o para crear experiencias más desafiantes y atractivas para un solo jugador.

Una aplicación fascinante de los MDP en el aprendizaje por refuerzo es el entrenamiento de modelos de IA para jugar a juegos de mesa complejos como el Go o el ajedrez. Estos juegos ofrecen un conjunto discreto de estados (configuraciones del tablero) y acciones (movimientos legales), lo que los hace adecuados para el modelado MDP. Los agentes de IA, a través de millones de partidas simuladas contra sí mismos, aprenden estrategias que pueden superar a los campeones humanos. Este proceso, conocido como autojuego, pone de relieve el potencial del aprendizaje por refuerzo basado en MDP para resolver problemas de gran complejidad y variabilidad.

Cuando diseñes o analices un modelo MDP, considera que los estados y las acciones deben ser lo más granulares posible para captar con precisión la dinámica del entorno.

Dominio de la Iteración del Valor del Proceso de Decisión de Markov

La Iteración del Valor es un potente algoritmo utilizado en el marco de los Procesos de Decisión de Markov (MDP) para encontrar la política óptima en problemas de toma de decisiones. Esta técnica actualiza iterativamente los valores asignados a cada estado con el fin de converger a la mejor acción posible para cada estado.Entender y aplicar la Iteración del Valor puede mejorar significativamente las estrategias de toma de decisiones en entornos complejos, donde los resultados son en parte aleatorios y en parte están bajo el control de un decisor.

El papel de la Iteración del Valor en los Procesos de Decisión de Markov

La Iteración del Valor desempeña un papel fundamental en la resolución de los MDP al emplear un enfoque sistemático para calcular las recompensas acumuladas máximas que pueden obtenerse de cada estado, identificando así la política óptima. Aprovecha el principio de la programación dinámica para mejorar iterativamente las estimaciones de valor de cada estado hasta que converjan a los valores óptimos.

Este proceso garantiza que, independientemente del estado inicial, el responsable de la toma de decisiones pueda hacer elecciones informadas, que conduzcan a la maximización del rendimiento esperado a lo largo del tiempo.

Consideremos el sencillo ejemplo de un laberinto en el que un agente pretende encontrar el camino más corto hacia la salida. Cada posición dentro del laberinto representa un estado, y en cada estado, el agente puede elegir entre un conjunto de acciones (moverse hacia arriba, hacia abajo, hacia la izquierda, hacia la derecha) para pasar a un nuevo estado. Aplicando la Iteración del Valor, el agente evalúa y actualiza sistemáticamente los valores de tomar cada acción en cada estado, revelando en última instancia el camino óptimo hacia la salida en función de las recompensas maximizadas (o los costes minimizados) de realizar movimientos específicos.

Guía paso a paso de la Iteración del Valor del Proceso de Decisión de Markov

La implementación de la Iteración del Valor implica una serie de pasos secuenciales, cada uno de los cuales contribuye a refinar las estimaciones del valor de los estados y, en consecuencia, a identificar la política óptima. El algoritmo itera sobre todos los estados, calculando la utilidad esperada de cada acción y seleccionando la acción que resulte en el valor más alto hasta que la función de valor se estabilice en todos los estados.

- Inicializa el valor de todos los estados a cero (o a un valor arbitrario).

- Para cada estado, calcula la utilidad esperada de todas las acciones posibles.

- Actualiza el valor del estado para que refleje el máximo rendimiento esperado.

- Repite el proceso para todos los estados hasta que el cambio en los valores esté por debajo de un pequeño umbral ( extit{indicando la convergencia}).

- Una vez que los valores hayan convergido, extrae la política eligiendo la acción que maximice el rendimiento para cada estado basándote en la función de valor final.

\(V^{(k+1)}(s) = \max_a \suma_{s'} P(s' | s, a) [R(s, a, s') + \gamma V^{(k)}(s')]\)Esta fórmula representa el núcleo de la Iteración del Valor, donde \(V^{(k+1)}(s)\) es el valor actualizado del estado \(s\) en la iteración \(k+1\), \(\max_a\) denota el valor máximo sobre todas las acciones posibles, \(P(s'|s, a)\) es la probabilidad de pasar al estado \(s'\) desde el estado \(s\) realizando la acción \(a\), \(R(s, a, s')\) es la recompensa recibida tras pasar de \(s\) a \(s'\) realizando la acción \(a), y \(\gamma\) es el factor de descuento que indica la importancia de las recompensas futuras.

Un factor de descuento alto (cercano a 1) en la Iteración del Valor implica una mayor importancia de las recompensas futuras, lo que influye en el decisor para que adopte una perspectiva a largo plazo.

Al aplicar la Iteración del Valor, un reto práctico es determinar cuándo detener el proceso de iteración. Normalmente, se establece un umbral ( extit{e.}, un valor pequeño como 0,01) para el cambio de valor entre iteraciones. Cuando la diferencia máxima de valor para cualquier estado entre dos iteraciones consecutivas es inferior a este umbral, se considera que el algoritmo ha convergido en una solución óptima. La Iteración del Valor es computacionalmente intensiva para grandes espacios de estados, pero su capacidad para encontrar la política óptima en problemas complejos de toma de decisiones la convierte en una herramienta valiosa en campos que van desde la robótica a las finanzas.

La propiedad de convergencia de la Iteración del Valor está garantizada por la ecuación de Bellman, que subyace a su solidez teórica. Esta ecuación establece que el valor de un estado bajo una política óptima debe ser igual al rendimiento esperado de la mejor acción tomada en ese estado. El enfoque iterativo de la Iteración del Valor aplica eficazmente este principio hasta que se minimizan las diferencias en la función de valor en todos los estados, garantizando que la política derivada sea lo más cercana posible al óptimo dentro de las restricciones del modelo.

Conceptos avanzados de los Procesos de Decisión de Markov

Explorar los conceptos avanzados de los Procesos de Decisión de Markov (PDM) permite comprender mejor la toma de decisiones en entornos complejos e inciertos. Estos conceptos, incluida la resolución de la ecuación de Bellman, la navegación por espacios parcialmente observables y las implicaciones de los factores de descuento, son fundamentales para refinar estrategias en diversas aplicaciones, desde la inteligencia artificial a la investigación operativa.

Resolución de la ecuación de Bellman Proceso de decisión de Markov

La ecuación de Bellman es fundamental en la teoría de los Procesos de Decisión de Markov, ya que proporciona una descomposición recursiva para la decisión política óptima. Al descomponer el proceso de decisión en piezas más pequeñas y manejables, ofrece un esquema matemático para aproximarse secuencialmente a la toma de decisiones óptima.

La ecuación de Bellman para un Proceso de Decisión de Markov viene dada por la fórmula \[V^*(s) = \max_a \left( R(s,a) + \gamma \sum_{s'} P(s'|s,a) V^*(s') \right)\], donde \(V^*(s)\) es el valor óptimo de estar en el estado \(s\), \(R(s,a)\) es la recompensa recibida tras realizar la acción \(a\) en el estado \(s\), \(P(s'|s,a)\) es la probabilidad de pasar al estado \(s'\) desde el estado \(s\) realizando la acción \(a\), y la suma se realiza sobre todos los posibles estados siguientes \(s'\).

Consideremos un mundo cuadriculado simple en el que un agente intenta navegar hasta una posición de meta desde un punto de partida. Cada celda de la cuadrícula representa un estado, y las acciones incluyen moverse en las direcciones cardinales. El objetivo del agente es llegar al destino con un número mínimo de movimientos. En este escenario, la aplicación de la ecuación de Bellman ayuda al agente a evaluar la utilidad esperada de las acciones en cada estado, guiándolo hacia el objetivo de forma óptima.

La ecuación de Bellman supone la plena observabilidad del entorno, lo que implica que el estado capta toda la información relevante para la toma de decisiones.

Navegación en Procesos de Decisión de Markov Parcialmente Observables

No todos los entornos ofrecen información completa sobre el estado. Los Procesos de Decisión de Markov Parcialmente Observables (POMDP) amplían los MDP a escenarios en los que el agente sólo tiene un conocimiento incompleto del estado actual, lo que introduce una complejidad significativa en el proceso de toma de decisiones.

Un Proceso de Decisión de Markov Parcialmente Observable ( POMDP ) modela la toma de decisiones en entornos en los que el agente no tiene una visibilidad completa del estado actual. Introduce observaciones que proporcionan información parcial sobre el estado real, junto con un estado de creencia que representa la confianza del agente en encontrarse en un estado concreto.

Navegar por los POMDP a menudo requiere mantener y actualizar una creencia sobre el estado actual, basada en el historial de acciones y observaciones.

Un dron autónomo que vuela en un entorno con niebla, donde la visibilidad es limitada, puede modelarse como un POMDP. El dron dispone de sensores que proporcionan información parcialmente precisa sobre su entorno. Las decisiones sobre la trayectoria de vuelo deben tomarse basándose en estos datos incompletos, lo que requiere una estrategia que equilibre de forma óptima la exploración y la explotación basándose en la información conocida.

Implicaciones del factor de descuento en el proceso de decisión de Markov

El factor de descuento, denotado por \(\gamma\), es un parámetro crítico en los Procesos de Decisión de Markov. Influye en la valoración de las recompensas futuras, configurando el proceso de toma de decisiones al ponderar la importancia de las recompensas inmediatas frente a las futuras.

El factor de descuento \(\gamma\) en un MDP es un número entre 0 y 1 que cuantifica el valor actual de las recompensas futuras. Un \(\gamma\) más bajo valora menos las recompensas futuras, favoreciendo las recompensas inmediatas, mientras que un \(\gamma\) más alto da más valor a las recompensas futuras, fomentando estrategias que pueden acumular recompensas más significativas con el tiempo.

En el contexto de una aplicación de inversión sostenible, podría utilizarse un modelo MDP para decidir si invertir en empresas de beneficio rápido con recompensas inmediatas o en proyectos sostenibles con beneficios a largo plazo. Un factor de descuento más alto inclinaría el modelo hacia lo segundo, lo que pone de relieve la importancia estratégica de la \(\gamma\) en la planificación bajo incertidumbre.

Elegir el factor de descuento adecuado es fundamental, ya que afecta directamente a la optimalidad de la política derivada de la solución MDP.

La elección del factor de descuento tiene profundas implicaciones que van más allá de la simple valoración de las recompensas. Puede afectar significativamente a la tasa de convergencia de algoritmos como la Iteración del Valor y la Iteración de la Política utilizados para resolver MDP. Además, en entornos con dependencias a largo plazo o que requieren una exploración exhaustiva antes de obtener recompensas significativas, fijar \(\gamma\) cerca de 1 ayuda a garantizar que las recompensas a largo plazo se valoran adecuadamente, fomentando políticas más estratégicas y con visión de futuro.

Procesos de decisión de Markov - Puntos clave

- Un Proceso de Decisión de Markov (MDP) es un marco matemático para modelizar la toma de decisiones secuenciales en las que los resultados son en parte aleatorios y en parte están bajo el control del decisor, y que abarca estados, acciones, probabilidades de transición y recompensas.

- Los componentes clave de los MDP incluyen estados (situaciones/configuraciones del sistema), acciones (decisiones/transiciones entre estados), probabilidades de transición (probabilidad de transiciones entre estados) y recompensas (valor de realizar determinadas transiciones).

- La Iteración del Valor, un algoritmo dentro de los MDP, actualiza iterativamente los valores de los estados para encontrar la política óptima que maximice las recompensas acumuladas, guiándose por la ecuación de Bellman.

- Los Procesos de Decisión de Markov Parcialmente Observables (POMDP) se adaptan a entornos con información incompleta sobre el estado actual, incorporando estados de creencia y observaciones.

- El factor de descuento en un POMDP cuantifica el valor actual de las recompensas futuras, con un γ más bajo que favorece las recompensas inmediatas y un γ más alto que fomenta los beneficios a largo plazo.

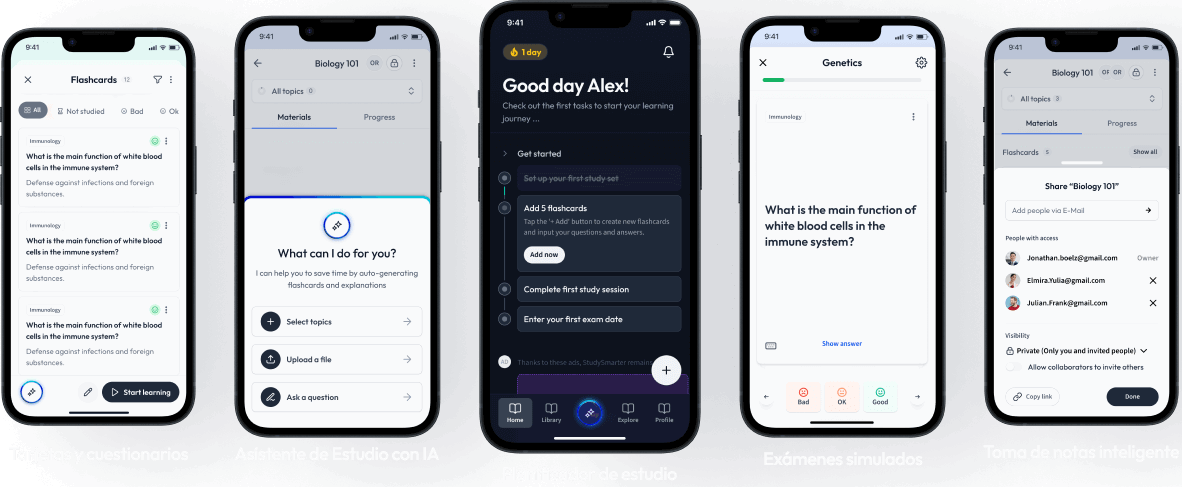

Aprende más rápido con las 0 tarjetas sobre Procesos de decisión de Markov

Regístrate gratis para acceder a todas nuestras tarjetas.

Preguntas frecuentes sobre Procesos de decisión de Markov

Acerca de StudySmarter

StudySmarter es una compañía de tecnología educativa reconocida a nivel mundial, que ofrece una plataforma de aprendizaje integral diseñada para estudiantes de todas las edades y niveles educativos. Nuestra plataforma proporciona apoyo en el aprendizaje para una amplia gama de asignaturas, incluidas las STEM, Ciencias Sociales e Idiomas, y también ayuda a los estudiantes a dominar con éxito diversos exámenes y pruebas en todo el mundo, como GCSE, A Level, SAT, ACT, Abitur y más. Ofrecemos una extensa biblioteca de materiales de aprendizaje, incluidas tarjetas didácticas interactivas, soluciones completas de libros de texto y explicaciones detalladas. La tecnología avanzada y las herramientas que proporcionamos ayudan a los estudiantes a crear sus propios materiales de aprendizaje. El contenido de StudySmarter no solo es verificado por expertos, sino que también se actualiza regularmente para garantizar su precisión y relevancia.

Aprende más